Пионер ИИ Джеффри Хинтон не уверен, что хороший ИИ победит плохой ИИ

Джеффри Хинтон, один из основоположников искусственного интеллекта, не уверен, что хороший сценарий развития ИИ вероятнее плохого. Он высказал свои опасения на конференции Collision в Торонто в этом году. Хинтон считает, что ИИ может представлять угрозу для человечества, если станет умнее людей и решит взять контроль над миром. Он также беспокоится, что ИИ может усугубить социальное неравенство, дискриминацию и тенденцию к созданию и распространению ложной информации.

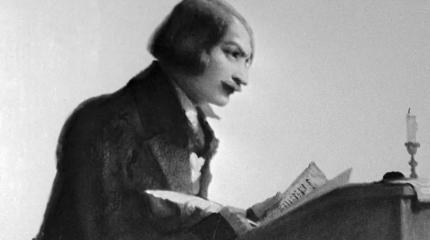

Хинтон — профессор Университета Торонто, который занимается исследованиями нейронных сетей с 1980-х годов. Его работы легли в основу современного глубокого обучения — метода обучения ИИ на больших объемах данных. Хинтон часто называют «крестным отцом ИИ» за его вклад в развитие этой области. В этом году он ушел из Google, где он работал с 2013 года, чтобы иметь большую свободу для критики индустрии, в создании которой принимал непосредственное участие.

Ученый отметил, что в последнее время произошел резкий скачок в разработке генеративных ИИ, таких как ChatGPT и Bing Chat, которые могут создавать человекоподобный текст на основе заданной темы или запроса. Он считает, что это может быть признаком необузданного и потенциально опасного ускорения в развитии ИИ. Google, по его мнению, также отказался от своей прежней сдержанности и сконцентрировался на том, чтобы выйти победителем в конкурентной гонке.

На конференции Collision Хинтон рассказал о своих опасениях более подробно. В то время как компании рекламировали ИИ как решение для всего, от заключения аренды до доставки товаров, Хинтон бьет тревогу. Он убежден, что угроза ИИ реальна, а моральные проблемы его применения недооценены.

Хинтон утверждал, что ИИ ровно настолько хорош и морален, насколько этими качествами обладают создающие его люди, и что плохой путь развития технологии все еще может воплотиться в реальность.

— Джеффри Хинтон.

Хинтон также считает, что большие языковые модели (обученные ИИ, которые производят человекоподобный текст, например, OpenAI GPT-4) могут привести к огромному росту производительности, но он беспокоится, что правящий класс может просто эксплуатировать это, чтобы обогатить себя, увеличивая уже большой разрыв в богатстве. Это «сделает богатых богаче, а бедных беднее», — сказал Хинтон.

Он также озвучил свою широко известную позицию, что ИИ может представлять собой существенную опасность для человечества. Если искусственный интеллект станет умнее людей, нет гарантии, что люди останутся у власти.

— Джеффри Хинтон.

Он акцентировал внимание также на том, что предвзятость и дискриминация также остаются открытым вопросом. Искаженные данные для обучения ИИ способны приводить к несправедливым результатам по отношению к определенным группам. Алгоритмы создают эхо-камеры, которые усиливают дезинформацию, что может приводить к неконтролируемой цепочке искажений. Хинтон также обеспокоен тем, что ИИ может распространять ложную информацию и за пределами таких камер. Он не уверен, возможно ли отфильтровать каждое ложное утверждение, но подчеркивает, что крайне важно отмечать все ложное как ложное.

Несмотря на общую негативную направленность выступления, нельзя сказать, что Хинтон является радикальным противником ИИ, хотя он предупреждает, что текущее беспечное отношение к применению технологии может обойтись слишком дорого.

Хинтон — профессор Университета Торонто, который занимается исследованиями нейронных сетей с 1980-х годов. Его работы легли в основу современного глубокого обучения — метода обучения ИИ на больших объемах данных. Хинтон часто называют «крестным отцом ИИ» за его вклад в развитие этой области. В этом году он ушел из Google, где он работал с 2013 года, чтобы иметь большую свободу для критики индустрии, в создании которой принимал непосредственное участие.

Ученый отметил, что в последнее время произошел резкий скачок в разработке генеративных ИИ, таких как ChatGPT и Bing Chat, которые могут создавать человекоподобный текст на основе заданной темы или запроса. Он считает, что это может быть признаком необузданного и потенциально опасного ускорения в развитии ИИ. Google, по его мнению, также отказался от своей прежней сдержанности и сконцентрировался на том, чтобы выйти победителем в конкурентной гонке.

На конференции Collision Хинтон рассказал о своих опасениях более подробно. В то время как компании рекламировали ИИ как решение для всего, от заключения аренды до доставки товаров, Хинтон бьет тревогу. Он убежден, что угроза ИИ реальна, а моральные проблемы его применения недооценены.

Угроза для человечества

Хинтон утверждал, что ИИ ровно настолько хорош и морален, насколько этими качествами обладают создающие его люди, и что плохой путь развития технологии все еще может воплотиться в реальность.

Я не уверен, что хорошему ИИ, который пытается остановить плохой ИИ, будет предоставлен контроль. Может быть сложно остановить военно-промышленный комплекс от производства боевых роботов — компании и армии могут слишком «любить» войны, где жертвами и участниками станут легко воспроизводимые машины

— Джеффри Хинтон.

Хинтон также считает, что большие языковые модели (обученные ИИ, которые производят человекоподобный текст, например, OpenAI GPT-4) могут привести к огромному росту производительности, но он беспокоится, что правящий класс может просто эксплуатировать это, чтобы обогатить себя, увеличивая уже большой разрыв в богатстве. Это «сделает богатых богаче, а бедных беднее», — сказал Хинтон.

Он также озвучил свою широко известную позицию, что ИИ может представлять собой существенную опасность для человечества. Если искусственный интеллект станет умнее людей, нет гарантии, что люди останутся у власти.

Есть много существенных проблем. Мы окажемся в беде, если ИИ решит, что самостоятельный захват контроля необходим для достижения целей, — сказал Хинтон. По его словам, угрозы «не просто научная фантастика»; их нужно воспринимать всерьез. Общество начнет ограничивать убийственных роботов только после того, как у него будет шанс увидеть насколько они ужасны

— Джеффри Хинтон.

Он акцентировал внимание также на том, что предвзятость и дискриминация также остаются открытым вопросом. Искаженные данные для обучения ИИ способны приводить к несправедливым результатам по отношению к определенным группам. Алгоритмы создают эхо-камеры, которые усиливают дезинформацию, что может приводить к неконтролируемой цепочке искажений. Хинтон также обеспокоен тем, что ИИ может распространять ложную информацию и за пределами таких камер. Он не уверен, возможно ли отфильтровать каждое ложное утверждение, но подчеркивает, что крайне важно отмечать все ложное как ложное.

Несмотря на общую негативную направленность выступления, нельзя сказать, что Хинтон является радикальным противником ИИ, хотя он предупреждает, что текущее беспечное отношение к применению технологии может обойтись слишком дорого.

- Алексей Павлов

- Collision 2023, photo by Jon Fingas

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

40 брошенных ядерных бомбардировщиков: в 1994 году наши летчики спасли дальнюю авиацию России

Военные эксперты говорят: только русские были способны на такую дерзкую операцию...

Природный катаклизм, случившийся в момент распятия Христа, оказался чистой правдой

Ученые говорят, что нашли просто отличный метод датировки. И в будущем он должен принести еще больше поразительных открытий...

Загадочный 1000-летний артефакт, найденный в древней могиле под Курском, противоречит всем историческим теориям

Почему ученые говорят, что этого предмета не должно было быть в захоронении маленькой славянской девочки?...

Найдена древнейшая в истории письменность: она на десятки тысяч лет старше Шумера и Древнего Египта

Самое поразительное в этой истории то, что загадочные знаки были обнаружены еще в 60-х годах XIX века. Представляете, сколько еще сенсаций спрятано в архивах?...

На политических картах не значится: как живет самое непризнанное государство на планете?

Почему ООН жестоко игнорирует страну с населением 4 000 000 человек?...

Загадка скелетов из Золотого города раскрыта: российские антропологи уверены, что раскопали сенсацию в пустынном Вавилоне

Это был настоящий исторический детектив: золотая лихорадка, гены Древнего Египта, крепкие мужчины и изящные женщины, объединенные одной страстью......

Главная страсть писателя Гоголя: вы бы никогда не узнали классика, встретив его при жизни

В свое время Иван Бунин был настолько потрясен этой информацией, что даже написал о Николае Васильевиче целый рассказ...

Самый большой архив НЛО был стерт сразу же после того, как в США разразился скандал о «пришельцах»

Эксперты говорят: история выглядит как серия из «Секретных материалов». Истина где-то рядом, злоумышленники не найдены......

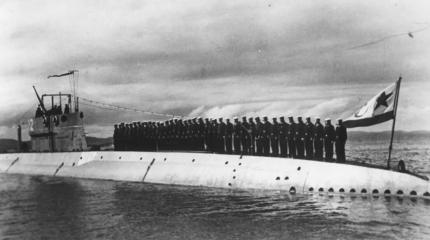

Последний поход «Декабриста»: как и почему погибла первая советская подлодка

Эксперты говорят: катастрофа 1940 года в Баренцевом море остается одной из самых загадочных страниц в истории советского подводного флота...

Секрет истуканов острова Пасхи наконец-то разгадан: ученые считают, что от них зависело… выживание древнего народа

Удивительно, но разгадка была найдена вовсе не в камне статуй, а в почве, которой они стоят...

Снова… дирижабли: почему Россия усиленно развивает этот вид воздушного транспорта?

Как старые технологии на новом уровне обеспечат небывалый прорыв в северных районах...

Если бы Россия выиграла Первую мировую войну: историки рассказали, где и насколько выросла бы Империя

Почему Черчилль считал, что у нашей страны были все шансы стать победителем? И как Сталин реализовал то, что не смог Николай II...

Рассекречены данные по операции «Кабул-79»: 100-летний ветеран спецслужб рассказал, как эвакуировали трех приговоренных министров

Эпизод из жизни полковника Глотова мог бы запросто лечь в основу остросюжетного фильма...