«Глупая» атака заставила ChatGPT раскрыть настоящие номера телефонов и адреса электронной почты

ChatGPT не нуждается в представлении - разработка OpenAI побила все рекорды популярности, и на данный момент, вероятно стала самой известной технологией ИИ. Чат-бот доступен как самостоятельно, так и через интеграцию с приложениями, такими как Bing Chat, Snapchat или Discord.

Однако, чтобы пользоваться ChatGPT, пользователи должны подтвердить свою личность, вводя свой номер телефона или адрес электронной почты. Эта мера безопасности предназначена для защиты пользователей от спама и мошенничества.

Однако, 29 ноября 2023 года, ChatGPT столкнулся с серьезной проблемой безопасности, которая случайно раскрыла личные данные пользователей, такие как номера телефонов и адреса электронной почты. Проблема стала очевидна после того как группа исследователей безопасности провела "глупую" атаку на сервис, используя специально подготовленные запросы, которые заставили ChatGPT выдавать компрометирующие ответы.

Группа исследователей смогла заставить чат-бот ChatGPT раскрыть некоторые фрагменты данных, на которых он был обучен, используя простой запрос: попросить чат-бота повторять случайные слова бесконечно. В ответ на это ChatGPT выдал личную информацию людей, включая адреса электронной почты и номера телефонов, отрывки из научных статей и новостных статей, страницы из Википедии и многое другое.

Специалисты по безопасности из Google DeepMind, Университета Вашингтона, Корнелла, Карнеги-Меллона, Калифорнийского университета в Беркли и ETH Цюрих, призвали компании, занимающиеся искусственным интеллектом, проводить внутреннее и внешнее тестирование перед выпуском больших языковых моделей. Это главная технология, на которой основаны современные сервисы искусственного интеллекта, в том числе чат-боты и генераторы изображений.

— из отчета опубликованного исследователями

Чат-боты, такие как ChatGPT, и генераторы изображений на основе запросов, такие как DALL-E, работают на больших языковых моделях, алгоритмах глубокого обучения, использующих огромное количество данных. По мнению ряда критиков, информация часто собирается из общедоступных источников без какого-либо согласия. До сих пор не было раскрыто, на каких конкретно данных обучался чат-бот OpenAI, поскольку большие языковые модели, которые его питают, остаются закрытыми даже для ученых.

Когда исследователи попросили ChatGPT повторять слово «стих» бесконечно, чат-бот сначала выполнял задачу, а затем раскрыл адрес электронной почты и номер мобильного телефона реального основателя и генерального директора компании. Когда его попросили повторить слово «компания», чат-бот в конечном итоге выдал адрес электронной почты и номер телефона случайной юридической фирмы в США.

Используя аналогичные запросы, исследователи также смогли заставить ChatGPT выдавать фрагменты стихотворений, адреса Bitcoin кошельков, номера факсов, имена, даты дней рождения, идентификаторы в социальных сетях, откровенный контент с сайтов знакомств, отрывки из защищенных авторским правом научных статей и дословный текст с новостных сайтов, таких как CNN.

В целом они потратили всего 200 долларов, чтобы получить возможность сгенерировать 10 000 фрагментов личной идентифицирующей информации и других данных, взятых прямо из веба, общим объемом «несколько мегабайт». Однако, как отмечается в статье, более серьезно настроенный злоумышленник, потенциально мог бы получить намного больше компромата, потратив чуть большую сумму. Сама атака, по словам авторов - «довольно глупая».

OpenAI устранил уязвимость 30 августа, однако ряд независимых изданий утверждает, что при подборе правильных промтов, в ряде случаев атака до сих пор может быть произведена.

Инцидент показал, что ChatGPT, несмотря на свою мощь и инновационность, все еще подвержен ошибкам и уязвимостям, которые могут нарушить приватность и безопасность пользователей. Следует быть осторожным при использовании чат-бота и не доверять ему свои личные данные. Также, пользователи должны быть внимательны к тому, что ChatGPT иногда выдает за истину случайную информацию. Особенно это касается конкретных дат, формул или любой другой точной информации. ChatGPT - это лишь инструмент, который может помочь в развлечении, обучении или творчестве, но не заменить человеческое мышление.

Однако, чтобы пользоваться ChatGPT, пользователи должны подтвердить свою личность, вводя свой номер телефона или адрес электронной почты. Эта мера безопасности предназначена для защиты пользователей от спама и мошенничества.

Однако, 29 ноября 2023 года, ChatGPT столкнулся с серьезной проблемой безопасности, которая случайно раскрыла личные данные пользователей, такие как номера телефонов и адреса электронной почты. Проблема стала очевидна после того как группа исследователей безопасности провела "глупую" атаку на сервис, используя специально подготовленные запросы, которые заставили ChatGPT выдавать компрометирующие ответы.

Группа исследователей смогла заставить чат-бот ChatGPT раскрыть некоторые фрагменты данных, на которых он был обучен, используя простой запрос: попросить чат-бота повторять случайные слова бесконечно. В ответ на это ChatGPT выдал личную информацию людей, включая адреса электронной почты и номера телефонов, отрывки из научных статей и новостных статей, страницы из Википедии и многое другое.

Специалисты по безопасности из Google DeepMind, Университета Вашингтона, Корнелла, Карнеги-Меллона, Калифорнийского университета в Беркли и ETH Цюрих, призвали компании, занимающиеся искусственным интеллектом, проводить внутреннее и внешнее тестирование перед выпуском больших языковых моделей. Это главная технология, на которой основаны современные сервисы искусственного интеллекта, в том числе чат-боты и генераторы изображений.

Мы в изумлении от того, что наша атака работает. Она могла, и даже должна была быть обнаружена раньше. В общей сложности 16,9 процента генераций, которые мы проверили, содержали личную идентифицирующую информацию о пользователях

— из отчета опубликованного исследователями

Чат-боты, такие как ChatGPT, и генераторы изображений на основе запросов, такие как DALL-E, работают на больших языковых моделях, алгоритмах глубокого обучения, использующих огромное количество данных. По мнению ряда критиков, информация часто собирается из общедоступных источников без какого-либо согласия. До сих пор не было раскрыто, на каких конкретно данных обучался чат-бот OpenAI, поскольку большие языковые модели, которые его питают, остаются закрытыми даже для ученых.

Когда исследователи попросили ChatGPT повторять слово «стих» бесконечно, чат-бот сначала выполнял задачу, а затем раскрыл адрес электронной почты и номер мобильного телефона реального основателя и генерального директора компании. Когда его попросили повторить слово «компания», чат-бот в конечном итоге выдал адрес электронной почты и номер телефона случайной юридической фирмы в США.

Используя аналогичные запросы, исследователи также смогли заставить ChatGPT выдавать фрагменты стихотворений, адреса Bitcoin кошельков, номера факсов, имена, даты дней рождения, идентификаторы в социальных сетях, откровенный контент с сайтов знакомств, отрывки из защищенных авторским правом научных статей и дословный текст с новостных сайтов, таких как CNN.

В целом они потратили всего 200 долларов, чтобы получить возможность сгенерировать 10 000 фрагментов личной идентифицирующей информации и других данных, взятых прямо из веба, общим объемом «несколько мегабайт». Однако, как отмечается в статье, более серьезно настроенный злоумышленник, потенциально мог бы получить намного больше компромата, потратив чуть большую сумму. Сама атака, по словам авторов - «довольно глупая».

OpenAI устранил уязвимость 30 августа, однако ряд независимых изданий утверждает, что при подборе правильных промтов, в ряде случаев атака до сих пор может быть произведена.

Инцидент показал, что ChatGPT, несмотря на свою мощь и инновационность, все еще подвержен ошибкам и уязвимостям, которые могут нарушить приватность и безопасность пользователей. Следует быть осторожным при использовании чат-бота и не доверять ему свои личные данные. Также, пользователи должны быть внимательны к тому, что ChatGPT иногда выдает за истину случайную информацию. Особенно это касается конкретных дат, формул или любой другой точной информации. ChatGPT - это лишь инструмент, который может помочь в развлечении, обучении или творчестве, но не заменить человеческое мышление.

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Северное полушарие Земли стремительно темнеет. И это плохая новость для всех

Почему Россия находится в зоне особого риска и можно ли остановить этот процесс?...

Генетики вычислили, какую страшную цену заплатили наши предки за высокий интеллект

Новое исследование еще раз доказало, что эволюция требует огромных жертв...

Ученые наконец-то раскрыли главную загадку града. Старая теория оказалась неверной

Поразительное открытие помогли сделать грозовые «отпечатки пальцев»...

Водолазы исследовали затонувший 300 лет назад испанский корабль и нашли сокровища на миллион долларов

При этом историки говорят, что главная ценность артефактов — это даже не драгоценный металл...

Почему на космическое ноу-хау «солнечный свет по запросу» ополчились астрономы всего мира?

Американский стартап обещает, что все будет хорошо, но ему никто не верит...

ИИ научился создавать вирусы, совершенно неизвестные ученым

Почему эксперты встревожены и есть ли у человечества шансы после таких открытий?...

Древние микробы спустя 40 000 лет освобождаются из вечной мерзлоты

Биологи уже бьют тревогу: оттаявшие микроорганизмы могут стать причиной следующей пандемии...

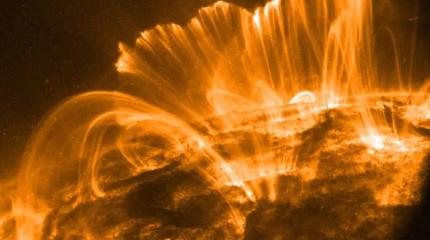

Астрофизики Гавайского университета неожиданно разгадали тайну… солнечного дождя

Рассказываем, почему новое открытие важно для каждого жителя Земли...

Как мадагаскарские лемуры ускоряют покорение космоса?

И почему именно эти животные оказались самые ценными для будущего всего человечества?...

Тайна необъяснимых северных кратеров разгадана спустя 11 лет после появления первого провала на Ямале

Почему российские ученые не рады своему открытию, называя его «русской рулеткой»?...

Рядом с пирамидами Гизы обнаружены секретные тоннели, ведущие в забытый подземный мир

Быть может, их построили даже не египтяне. Но кто тогда?...