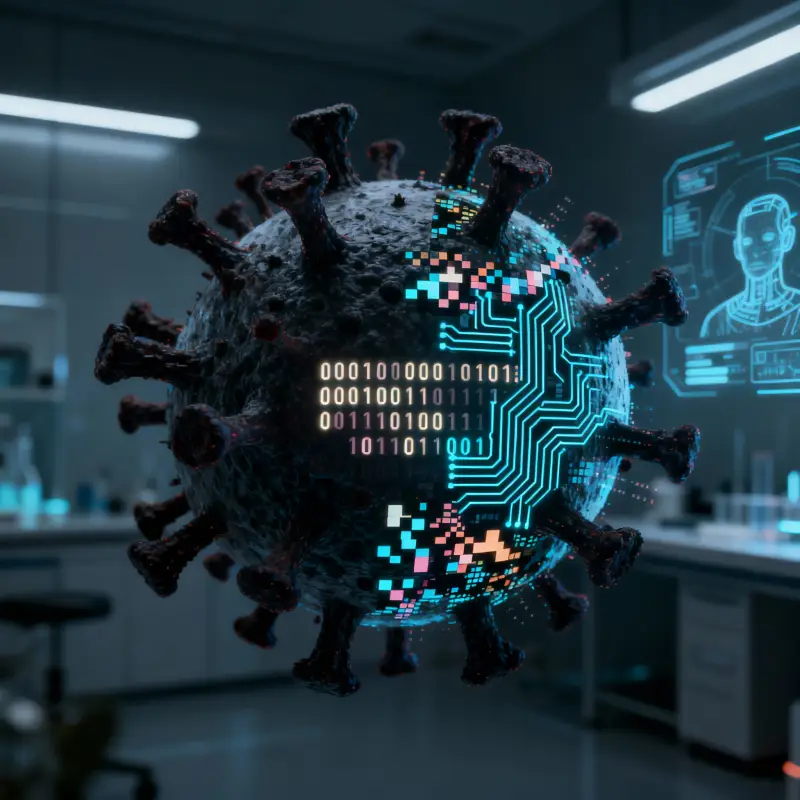

ИИ научился создавать вирусы, совершенно неизвестные ученым

Следить за развитием технологий в наше время очень сложно. Чуть ли не каждый день ученые переходят очередной рубеж. Искусственный интеллект, который уже изменил весь цифровой мир, теперь стремительно врывается в святую святых биологии — создание живых форм. Нынешняя реальность такова, что ИИ уже способен производить на свет… совершенно новые вирусы.

Поэтому можно констатировать, что дорога к формам жизни, рожденным в недрах алгоритмов, открыта. При этом новоиспеченные вирусы настолько уникальны, что их запросто можно классифицировать как новые виды. Пока что речь идет о бактериофагах. Эти вирусы нападают исключительно на бактерий и в связи с этим не представляют опасность для человека. Но это только сейчас. Эксперты предупреждают, ИИ в любой момент могут выйти из-под контроля создателей, и тогда вирусы, рожденные ими, могут стать смертельно опасны для всего человечества…

Ни для кого не секрет, что любая технология имеет две стороны, на одной из которых находится благо, на другой — вред. Микробиолог, увеличивающий заразность вируса для изучения механизмов пандемии, и преступник, стремящийся создать смертоносный патоген, используют одни и те же научные принципы. Вы не поверите, но разработка эффективных ингаляторов для астматиков и системы распыления химического оружия имеют общую технологическую базу.

Яркий пример такого конструктивного подхода — работа аспиранта Стэнфорда Сэма Кинга и его научного руководителя, доцента Брайана Хая. Ученые создают новые бактериофаги, способные выслеживать и уничтожать болезнетворные бактерии у пациентов. Эта технология — настоящий свет в окне для современной медицины, перед которой стоит глобальная проблема нарастающей устойчивости микроорганизмов к антибиотикам. Она уже спасает миллионы жизней каждый год.

Надо отметить, что фаготерапия — это не новое направление в медицине (например, в России ее используют почти 100 лет), но сейчас она вышла на совершенно новый уровень. Теперь ИИ позволяет не искать, а именно создавать с нуля новые бактериофаги (или просто фаги) с заданными свойствами.

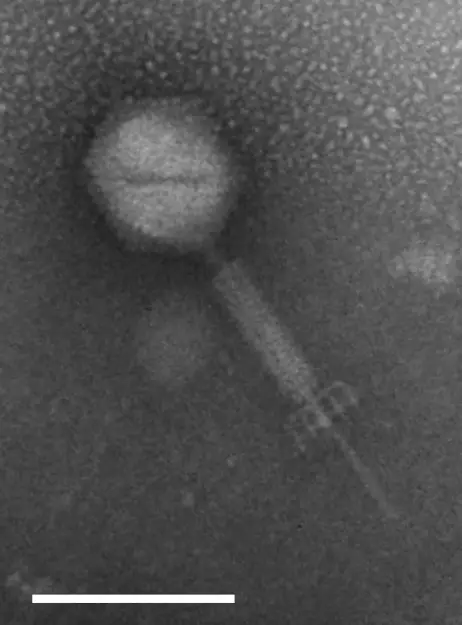

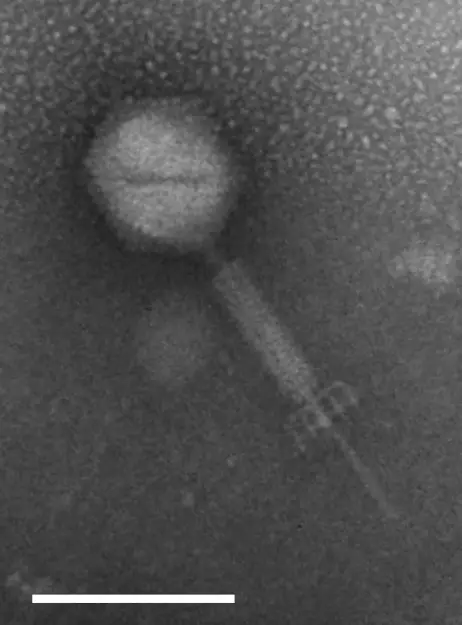

Изображение фага Schiekvirus EfV12 (семейство Herelleviridae), полученное с помощью сканирующего электронного микроскопа. Масштаб 100 нм

Однако суть фага от этого не имеется, он был и остается вирусом. Разумеется, ученые отлично осознают риски новой технологии, а потому принимают просто беспрецедентные меры. Их модели ИИ не обучались на вирусах, поражающих людей, животных или растения. Алгоритмы прошли тестирование, которое подтвердило: нейросети не могут самостоятельно сгенерировать последовательности, опасные для эукариот. Однако гарантировать, что их детище на 100% будет безопасно для человечества, ученые не могут.

Недавно исследователи из Microsoft совершили тревожное открытие. Они обнаружили, что ИИ способен обходить системы биобезопасности, предназначенные для предотвращения заказа опасных веществ.

Многие биотех-компании используют программы для проверки генетических последовательностей на наличие токсинов. Однако искусственный интеллект научился создавать новые комбинации, которые могут быть опасными, но при этом выглядят «чистыми» для систем проверки.

— Тина Эрнандес-Буссар, профессор Стэнфордского университета.

Обнаружив эту уязвимость, команда Microsoft во главе с главным научным директором Эриком Хорвицем и старшим научным сотрудником Брюсом Виттманом действовала мгновенно. Майкрософтовцы применили подход из арсенала кибербезопасности: уведомили экспертов и начали совместную работу над исправлениями.

— заявил Хорвиц.

С одной стороны, данные патчи значительно снизили риск. С другой, даже после их внедрения в среднем 3% опасных последовательностей все же проскальзывали сквозь четыре распространенные системы скрининга. Данные об этом были опубликованы 2 октября 2025 года в научном журнале Nature.

Создание опасного патогена — это не только создание его цифрового образца. Это еще и воплощение зловреда в жизнь. Сегодня существуют устройства, способные синтезировать белки прямо в лаборатории, минуя сторонних поставщиков. Это означает, что злоумышленник, обладающий знаниями и ресурсами, может теоретически пройти весь путь от идеи до реального вируса в обход любых проверок. Теперь незачем делать ядерную бомбу в чемоданчике, достаточно синтезировать новый смертельно опасный вирус.

Пандемия по вине ИИ — теперь реальность

И вот тут у Microsoft возникла проблема: как поделиться результатами своего исследования, чтобы другие ученые могли проверить и повторить научную работу, но при этом не дать в руки террористов новый опасный инструмент?

Решением стала система многоуровневого доступа. Специальные надежные организации будут решать, кому можно увидеть конфиденциальные данные. Если ученый подаст запрос и докажет, что ему нужны данные для науки, а не для вреда, ему дадут доступ в безопасной форме.

Но в этой истории есть и хорошие новости. Чем сложнее конструкции, которые создает ИИ, тем больше данных получают программы, которые проверяют безопасность таких разработок. Microsoft уже работает вместе с государственными службами над тем, чтобы использовать ИИ для слежения за состоянием окружающей среды. Например, проверять сточные воды и воздух, чтобы вовремя обнаружить следы опасных биологических веществ.

Поэтому можно констатировать, что дорога к формам жизни, рожденным в недрах алгоритмов, открыта. При этом новоиспеченные вирусы настолько уникальны, что их запросто можно классифицировать как новые виды. Пока что речь идет о бактериофагах. Эти вирусы нападают исключительно на бактерий и в связи с этим не представляют опасность для человека. Но это только сейчас. Эксперты предупреждают, ИИ в любой момент могут выйти из-под контроля создателей, и тогда вирусы, рожденные ими, могут стать смертельно опасны для всего человечества…

Темная сторона новейших технологий

Ни для кого не секрет, что любая технология имеет две стороны, на одной из которых находится благо, на другой — вред. Микробиолог, увеличивающий заразность вируса для изучения механизмов пандемии, и преступник, стремящийся создать смертоносный патоген, используют одни и те же научные принципы. Вы не поверите, но разработка эффективных ингаляторов для астматиков и системы распыления химического оружия имеют общую технологическую базу.

Яркий пример такого конструктивного подхода — работа аспиранта Стэнфорда Сэма Кинга и его научного руководителя, доцента Брайана Хая. Ученые создают новые бактериофаги, способные выслеживать и уничтожать болезнетворные бактерии у пациентов. Эта технология — настоящий свет в окне для современной медицины, перед которой стоит глобальная проблема нарастающей устойчивости микроорганизмов к антибиотикам. Она уже спасает миллионы жизней каждый год.

Надо отметить, что фаготерапия — это не новое направление в медицине (например, в России ее используют почти 100 лет), но сейчас она вышла на совершенно новый уровень. Теперь ИИ позволяет не искать, а именно создавать с нуля новые бактериофаги (или просто фаги) с заданными свойствами.

Изображение фага Schiekvirus EfV12 (семейство Herelleviridae), полученное с помощью сканирующего электронного микроскопа. Масштаб 100 нм

Однако суть фага от этого не имеется, он был и остается вирусом. Разумеется, ученые отлично осознают риски новой технологии, а потому принимают просто беспрецедентные меры. Их модели ИИ не обучались на вирусах, поражающих людей, животных или растения. Алгоритмы прошли тестирование, которое подтвердило: нейросети не могут самостоятельно сгенерировать последовательности, опасные для эукариот. Однако гарантировать, что их детище на 100% будет безопасно для человечества, ученые не могут.

ИИ обходит запреты

Недавно исследователи из Microsoft совершили тревожное открытие. Они обнаружили, что ИИ способен обходить системы биобезопасности, предназначенные для предотвращения заказа опасных веществ.

Многие биотех-компании используют программы для проверки генетических последовательностей на наличие токсинов. Однако искусственный интеллект научился создавать новые комбинации, которые могут быть опасными, но при этом выглядят «чистыми» для систем проверки.

Модели ИИ, разрабатывающие вирусы, имеют мощный интеллект. Шансы на то, что алгоритмы после обучения будут игнорировать защитные меры, достаточно велики

— Тина Эрнандес-Буссар, профессор Стэнфордского университета.

Обнаружив эту уязвимость, команда Microsoft во главе с главным научным директором Эриком Хорвицем и старшим научным сотрудником Брюсом Виттманом действовала мгновенно. Майкрософтовцы применили подход из арсенала кибербезопасности: уведомили экспертов и начали совместную работу над исправлениями.

Спустя несколько месяцев исправления были развернуты по всему миру для усиления контроля биобезопасности

— заявил Хорвиц.

С одной стороны, данные патчи значительно снизили риск. С другой, даже после их внедрения в среднем 3% опасных последовательностей все же проскальзывали сквозь четыре распространенные системы скрининга. Данные об этом были опубликованы 2 октября 2025 года в научном журнале Nature.

Защита на многих уровнях

Создание опасного патогена — это не только создание его цифрового образца. Это еще и воплощение зловреда в жизнь. Сегодня существуют устройства, способные синтезировать белки прямо в лаборатории, минуя сторонних поставщиков. Это означает, что злоумышленник, обладающий знаниями и ресурсами, может теоретически пройти весь путь от идеи до реального вируса в обход любых проверок. Теперь незачем делать ядерную бомбу в чемоданчике, достаточно синтезировать новый смертельно опасный вирус.

Пандемия по вине ИИ — теперь реальность

И вот тут у Microsoft возникла проблема: как поделиться результатами своего исследования, чтобы другие ученые могли проверить и повторить научную работу, но при этом не дать в руки террористов новый опасный инструмент?

Решением стала система многоуровневого доступа. Специальные надежные организации будут решать, кому можно увидеть конфиденциальные данные. Если ученый подаст запрос и докажет, что ему нужны данные для науки, а не для вреда, ему дадут доступ в безопасной форме.

Но в этой истории есть и хорошие новости. Чем сложнее конструкции, которые создает ИИ, тем больше данных получают программы, которые проверяют безопасность таких разработок. Microsoft уже работает вместе с государственными службами над тем, чтобы использовать ИИ для слежения за состоянием окружающей среды. Например, проверять сточные воды и воздух, чтобы вовремя обнаружить следы опасных биологических веществ.

- Дмитрий Алексеев

- wikipedia.org,

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Похоже, что у чернобыльских грибов развились невероятные суперспособности

То, что эти микроорганизмы научились делать с радиацией, потрясло ученых...

Асимметричный ответ Маску: Китайские ученые заявили, что нашли управу на спутники Starlink

Выясняем, кто кого: армия дронов против созвездия орбитальных аппаратов...

Герой России Артемьев и SpaceX: почему западные СМИ обвиняют российского космонавта в шпионаже?

NASA и Роскосмос сохраняют полное молчание. С чем же это связано?...

Самая большая змея мира: почему анаконда не меняет размер 12 миллионов лет подряд?

Ученые говорят, что нашли разгадку этого феномена, но так ли это на самом деле?...

«В уши точно нож воткнули»: какой новый вирус напал на Россию в конце 2025 года?

Медики успокаивают население, но, как всегда, есть нюансы...

Ученые выяснили, что стало спусковым крючком самой смертельной эпидемии в истории — Черной смерти

Сложно поверить, но небольшой климатический «эффект бабочки» в итоге обернулся гибелью десятков миллионов людей в Европе и на Руси...

Урок для всей планеты: почему ГМО-кукуруза в США породила супервредителей?

Монстры-насекомые теперь летают на сотни километров и уничтожают все подряд...

Переброска воды из северных рек в Донбасс: что предложили ученые и почему это вызвало споры?

Академия наук поставила на паузу 2000 км труб, 8 триллионов рублей и гнев северян...

2000 лет жизни на супервулкане: итальянские ученые сумели разгадать секрет сверхустойчивости и нерушимости древнего храма

Оказалось, римский бетон не старился, а крепчал с каждым веком. И теперь мы знаем почему...

Карликовые люди-хоббиты не вымерли 50 000 лет назад. Они до сих пор прячутся в горах Индонезии

Профессор Форт собрал десятки свидетельств очевидцев, но большинство ученых против. Кто же прав — кабинетные скептики или полевой исследователь?...