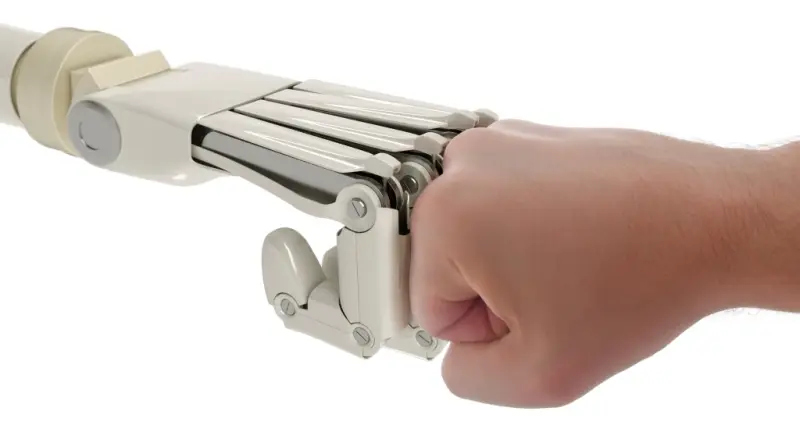

Можно ли дружить с машинами?

Искусственный интеллект все больше проникает в нашу жизнь. Мы пользуемся голосовыми ассистентами, навигаторами, переводчиками и другими умными приложениями. Мы работаем в командах с роботами, дронами и автономными транспортными средствами. Мы даже играем в компьютерные игры с ботами — программами, которые имитируют поведение человека.

Но насколько мы можем доверять этим машинам? И как они влияют на наше доверие к другим людям? Эти вопросы становятся все более актуальными в свете быстрого развития ИИ и появления новых форм смешанных коллективов из людей и машин.

Чтобы найти ответы на эти вопросы, ученые из Нью-Йоркского университета Абу-Даби провели серию онлайн-экспериментов, в которых участники играли в роли жертв, которые теряли часть своих денег из-за действий другого агента (человека или бота). Помощники могли компенсировать потери жертвы за свой счет, а контролеры могли штрафовать нарушителя. Доверяющие могли передавать свои деньги другому агенту, который мог их удвоить и вернуть или присвоить себе. Все эти роли могли выполнять как люди, так и боты.

Как вы бы поступили в такой ситуации? Кому бы вы доверяли больше — человеку или боту? И как бы вы относились к тому, кто помогает или штрафует вас, или вашего обидчика? Давайте разберемся.

Вот пример из эксперимента. Представьте, что вы играете в роли жертвы. Вы получаете 100 рублей и можете потратить их на что угодно. Но вдруг вы узнаете, что другой агент (назовем его Альфа) забрал у вас 50 рублей. Вы не знаете, кто он — человек или бот. Вы чувствуете себя обиженным и хотите вернуть свои деньги. Но вы не можете сделать это сами. Вам нужна помощь другого агента (назовем его Бета), который может дать вам 50 рублей из своего кармана. Вы тоже не знаете, кто он — человек или бот. Вы бы хотели, чтобы он помог вам, но не уверены, что он согласится. Ведь ему это ничего не даст, кроме убытка.

Как вы отнесетесь к Бета, если он поможет вам? А если он откажется? Скорее всего, вы будете благодарны ему за помощь и недовольны его отказом. Это логично, ведь он проявил к вам доброту и справедливость или наоборот. Но ваше доверие к Бета будет зависеть не только от его поведения, но и от того, какое поведение считается нормальным в вашем сообществе. То есть, что большинство людей и ботов готовы помогать жертвам и штрафовать нарушителей или нет. Если вы знаете, что такая норма есть и она широко распространена, то вы будете доверять Бета больше, чем если бы вы не знали об этом или если бы норма была другая. Это потому, что вы будете думать, что Бета не просто случайно или эгоистично поступил хорошо или плохо, а следовал общепринятому правилу. А это значит, что он, скорее всего, будет поступать так же и в будущем.

Но что, если вы не знаете, какая норма действует в вашем сообществе? Или если вы знаете, что норма есть, но не знаете, насколько она распространена и уважаема? В таком случае ваше доверие к Бета будет зависеть от того, кто он — человек или бот. Возможно, вы будете думать, что человеку легче понять и поддержать вас, чем машине. Или наоборот, что машина более надежна и последовательна, чем человек. В любом случае вы будете относиться к ним по-разному.

Именно это и выяснили ученые. Они измеряли уровень доверия к разным типам агентов в зависимости от их поведения и информации о нормах. Оказалось, что люди больше доверяют помощникам и контролерам, которые следуют нормам, чем тем, кто их нарушает. Также оказалось, что доверие к «адекватным» агентам связано с оценкой доверяющих о том, насколько эти нормы являются общепринятыми. Кроме того, установлено, что при определенных условиях информирование доверяющих о консенсусе по поводу помощи уменьшает различное отношение к машинам и людям, взаимодействующим с ними.

Что это значит для нас? Это значит, что мы можем научиться доверять машинам и понимать их мотивы. Но для этого нужно знать и соблюдать общие нормы сотрудничества. А это возможно только при условии, что мы общаемся с машинами и другими людьми открыто и честно. Только тогда мы сможем создавать смешанные коллективы из людей и машин, которые будут работать на благо всего человечества.

Но насколько мы можем доверять этим машинам? И как они влияют на наше доверие к другим людям? Эти вопросы становятся все более актуальными в свете быстрого развития ИИ и появления новых форм смешанных коллективов из людей и машин.

Чтобы найти ответы на эти вопросы, ученые из Нью-Йоркского университета Абу-Даби провели серию онлайн-экспериментов, в которых участники играли в роли жертв, которые теряли часть своих денег из-за действий другого агента (человека или бота). Помощники могли компенсировать потери жертвы за свой счет, а контролеры могли штрафовать нарушителя. Доверяющие могли передавать свои деньги другому агенту, который мог их удвоить и вернуть или присвоить себе. Все эти роли могли выполнять как люди, так и боты.

Как вы бы поступили в такой ситуации? Кому бы вы доверяли больше — человеку или боту? И как бы вы относились к тому, кто помогает или штрафует вас, или вашего обидчика? Давайте разберемся.

Вот пример из эксперимента. Представьте, что вы играете в роли жертвы. Вы получаете 100 рублей и можете потратить их на что угодно. Но вдруг вы узнаете, что другой агент (назовем его Альфа) забрал у вас 50 рублей. Вы не знаете, кто он — человек или бот. Вы чувствуете себя обиженным и хотите вернуть свои деньги. Но вы не можете сделать это сами. Вам нужна помощь другого агента (назовем его Бета), который может дать вам 50 рублей из своего кармана. Вы тоже не знаете, кто он — человек или бот. Вы бы хотели, чтобы он помог вам, но не уверены, что он согласится. Ведь ему это ничего не даст, кроме убытка.

Как вы отнесетесь к Бета, если он поможет вам? А если он откажется? Скорее всего, вы будете благодарны ему за помощь и недовольны его отказом. Это логично, ведь он проявил к вам доброту и справедливость или наоборот. Но ваше доверие к Бета будет зависеть не только от его поведения, но и от того, какое поведение считается нормальным в вашем сообществе. То есть, что большинство людей и ботов готовы помогать жертвам и штрафовать нарушителей или нет. Если вы знаете, что такая норма есть и она широко распространена, то вы будете доверять Бета больше, чем если бы вы не знали об этом или если бы норма была другая. Это потому, что вы будете думать, что Бета не просто случайно или эгоистично поступил хорошо или плохо, а следовал общепринятому правилу. А это значит, что он, скорее всего, будет поступать так же и в будущем.

Но что, если вы не знаете, какая норма действует в вашем сообществе? Или если вы знаете, что норма есть, но не знаете, насколько она распространена и уважаема? В таком случае ваше доверие к Бета будет зависеть от того, кто он — человек или бот. Возможно, вы будете думать, что человеку легче понять и поддержать вас, чем машине. Или наоборот, что машина более надежна и последовательна, чем человек. В любом случае вы будете относиться к ним по-разному.

Именно это и выяснили ученые. Они измеряли уровень доверия к разным типам агентов в зависимости от их поведения и информации о нормах. Оказалось, что люди больше доверяют помощникам и контролерам, которые следуют нормам, чем тем, кто их нарушает. Также оказалось, что доверие к «адекватным» агентам связано с оценкой доверяющих о том, насколько эти нормы являются общепринятыми. Кроме того, установлено, что при определенных условиях информирование доверяющих о консенсусе по поводу помощи уменьшает различное отношение к машинам и людям, взаимодействующим с ними.

Что это значит для нас? Это значит, что мы можем научиться доверять машинам и понимать их мотивы. Но для этого нужно знать и соблюдать общие нормы сотрудничества. А это возможно только при условии, что мы общаемся с машинами и другими людьми открыто и честно. Только тогда мы сможем создавать смешанные коллективы из людей и машин, которые будут работать на благо всего человечества.

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Турецкие археологи обнаружили затерянный мост, способный переписать всю раннюю историю человечества

Оказалось, что научная сенсация все это время... валялась у ученых буквально под ногами...

Секретная база в Гренландии, спрятанная 30-метровым слоем льда, угрожает всему миру

Гляциолог Уильям Колган говорит: «Американские военные думали, что это никогда не вскроется, но теперь...»...

Эксперты говорят: изобретение ученых из Перми решает одну из самых серьезных и опасных проблем в современной авиации

Американцы потратили на это десятки лет и миллиарды долларов, но открытие сделали в России...

В Антарктиде обнаружен метановый «спящий гигант», который очень быстро просыпается. И это плохая новость

Ученые в тревоге задаются вопросом: означают ли десятки газовых гейзеров под водой, что эффект домино уже запущен?...

В самом большом кратере Луны происходит что-то очень странное

Поэтому астронавты планируют туда заглянуть в самое ближайшее время...

Секретные спутники Илона Маска заподозрили в использовании запрещенных сигналов

Что это значит для России и чем могут ответить наши военные?...

Археологи поражены: 404 тысячи лет назад «римляне» спокойно разделали гигантского слона... 3-сантиметровыми ножичками

Получается, что древние охотники могли справиться с самым большим животным в Европе буквально голыми руками?...

Ученые обнаружили на Кавказе «ужасного» хищника, способного дробить черепа с одного укуса

Почему же 400-килограммовый монстр, побеждавший медведей и саблезубых тигров, все-таки исчез с лица планеты?...

«Черный ящик» раскрыл тайну летучей мыши, пожирающей птиц прямо в полете

Ученые совершенно не ожидали, что рукокрылый властелин ночного неба по свирепости и охотничьему мастерству даст фору даже соколам...

Ученые выяснили: в каком возрасте наш мозг достигает пика своей активности

Почему же 20-30 лет оказались стереотипом, далеким от реальной жизни?...

2700 дней понадобилось ученым, чтобы, наконец, раскрыть главную тайну гигантских скатов

Оказалось, что манты ныряют на 1250-метровую глубину вовсе не за едой и не спасаясь от хищников...

Мог ли великий художник Клод Моне видеть в ультрафиолетовом спектре, как пчела?

Историки уверены: после операции на глазах с французским живописцем стали происходит очень странные вещи...

В ближайшие 100 лет Юпитер «выстрелит» в Землю как минимум 342 раза

Российские ученые рассчитали: ближайшее «прицеливание» состоится уже 2031 году. Что вообще нам ожидать?...