В Китае мошенники обокрали мужчину с помощью дипфейковых видео и аудио, имитирующих его друга

Мошенничество с дипфейками в Китае усилило опасения, по поводу того, что искусственный интеллект позволит хакерам легко получить финансовую информацию пользователей. Сообщается, что хакеры с помощью передового программного обеспечения искусственного интеллекта убедили мужчину на севере Китая перевести деньги своему другу, но вместо этого перенаправили их на мошеннический счет.

Жертва находилась в Баотоу, регионе во внутренней Монголии, и местная полиция сообщила, что хакер использовал ИИ, чтобы воссоздать образ друга во время видеозвонка, включая его лицо и голос. Мошенничество с дипфейком заставило жертву поверить, что он переводил 4,3 миллиона юаней (622 000 долларов США) своему другу для внесения залога. Когда друг сказал жертве, что он не знал об инциденте, мужчина сообщил о мошенничестве властям, которые сообщили, что им удалось вернуть большую часть украденных денег, но они все еще работают над возвратом остальных средств.

Weibo, китайский сайт микроблогов, используется в качестве форума для обсуждения сохраняющейся угрозы мошенничества с дипфейками, а хэштег «#мошенничество с искусственным интеллектом происходит по всей стране» становится вирусным и набрал в понедельник более 120 миллионов просмотров.

— комментарий одного из пользователей Weibo.

Недавний инцидент произошел на фоне резко возросшего количества случаев мошенничества с использованием ИИ по всему миру. В особенности также возросло число сообщений о мошенниках, использующих технологию ИИ для воспроизведения голоса в преступных схемах с телефонными и видео звонками.

На фоне произошедшего министерство внутренней безопасности выпустило отчет, предупреждающий о мошенничестве с дипфейками.

— министерство внутренней безопасности Китая.

Не так давно в Великобритании произошел случай мошенничества, где преступники использовали схожий метод для совершения преступления. Генеральный директор местной энергетической компании перевел 220 000 евро (около 243 000 долларов США) на банковский счет венгерского поставщика после телефонного звонка от своего предполагаемого начальника. Голос на самом деле принадлежал мошеннику, который использовал голосовую технологию искусственного интеллекта, чтобы воспроизвести голос босса. Как позже сообщил директор в интервью изданию The Wall Street Journal, в момент звонка мошеннику удалось имитировать даже тонкий немецкий акцент начальника.

Между тем, в США полицейское управление на юге Висконсина еще в прошлом месяце предупредило жителей о подобной угрозе. Предупреждение появилось после получения ряда сообщений, о том, что людям звонил кто-то, кто звучал очень похоже на их родствеников.

— полицейское управление Чикаго.

Чтобы не стать жертвой, специалисты по безопасности рекомендуют позвонить человеку, который предположительно просил деньги в стороннем приложении или по телефону, а также произвести ряд других проверок, особенно, если речь идет о крупной сумме.

Жертва находилась в Баотоу, регионе во внутренней Монголии, и местная полиция сообщила, что хакер использовал ИИ, чтобы воссоздать образ друга во время видеозвонка, включая его лицо и голос. Мошенничество с дипфейком заставило жертву поверить, что он переводил 4,3 миллиона юаней (622 000 долларов США) своему другу для внесения залога. Когда друг сказал жертве, что он не знал об инциденте, мужчина сообщил о мошенничестве властям, которые сообщили, что им удалось вернуть большую часть украденных денег, но они все еще работают над возвратом остальных средств.

Weibo, китайский сайт микроблогов, используется в качестве форума для обсуждения сохраняющейся угрозы мошенничества с дипфейками, а хэштег «#мошенничество с искусственным интеллектом происходит по всей стране» становится вирусным и набрал в понедельник более 120 миллионов просмотров.

Могут ли правила информационной безопасности идти в ногу с методами этих людей? Данный случай показывает, что сгенерированные фотографии, голоса и видео уже могут быть использованы мошенниками

— комментарий одного из пользователей Weibo.

Недавний инцидент произошел на фоне резко возросшего количества случаев мошенничества с использованием ИИ по всему миру. В особенности также возросло число сообщений о мошенниках, использующих технологию ИИ для воспроизведения голоса в преступных схемах с телефонными и видео звонками.

На фоне произошедшего министерство внутренней безопасности выпустило отчет, предупреждающий о мошенничестве с дипфейками.

Очевидно, что серьезность и срочность текущей угрозы со стороны синтетических записей и звонков зависят от качества реализации фейка, точки зрения и обстоятельств того, кого пытаются обмануть. Спектр оценки опасений варьировался от «неотложной угрозы» до «не паникуйте, просто будьте готовы»

— министерство внутренней безопасности Китая.

Не так давно в Великобритании произошел случай мошенничества, где преступники использовали схожий метод для совершения преступления. Генеральный директор местной энергетической компании перевел 220 000 евро (около 243 000 долларов США) на банковский счет венгерского поставщика после телефонного звонка от своего предполагаемого начальника. Голос на самом деле принадлежал мошеннику, который использовал голосовую технологию искусственного интеллекта, чтобы воспроизвести голос босса. Как позже сообщил директор в интервью изданию The Wall Street Journal, в момент звонка мошеннику удалось имитировать даже тонкий немецкий акцент начальника.

Между тем, в США полицейское управление на юге Висконсина еще в прошлом месяце предупредило жителей о подобной угрозе. Предупреждение появилось после получения ряда сообщений, о том, что людям звонил кто-то, кто звучал очень похоже на их родствеников.

Мы пока не можем официально подтвердить, что это был голос, сгенерированный искусственным интеллектом, но мы хотим, чтобы наше сообщество знало, что такая технология существует.

Число подобных сценариев несомненно, будут увеличиваться по мере одновременного снижения стоимости и других ресурсов, необходимых для создания пригодных для использования дипфейков

Число подобных сценариев несомненно, будут увеличиваться по мере одновременного снижения стоимости и других ресурсов, необходимых для создания пригодных для использования дипфейков

— полицейское управление Чикаго.

Чтобы не стать жертвой, специалисты по безопасности рекомендуют позвонить человеку, который предположительно просил деньги в стороннем приложении или по телефону, а также произвести ряд других проверок, особенно, если речь идет о крупной сумме.

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Турецкие археологи обнаружили затерянный мост, способный переписать всю раннюю историю человечества

Оказалось, что научная сенсация все это время... валялась у ученых буквально под ногами...

Секретная база в Гренландии, спрятанная 30-метровым слоем льда, угрожает всему миру

Гляциолог Уильям Колган говорит: «Американские военные думали, что это никогда не вскроется, но теперь...»...

Эксперты говорят: изобретение ученых из Перми решает одну из самых серьезных и опасных проблем в современной авиации

Американцы потратили на это десятки лет и миллиарды долларов, но открытие сделали в России...

В Антарктиде обнаружен метановый «спящий гигант», который очень быстро просыпается. И это плохая новость

Ученые в тревоге задаются вопросом: означают ли десятки газовых гейзеров под водой, что эффект домино уже запущен?...

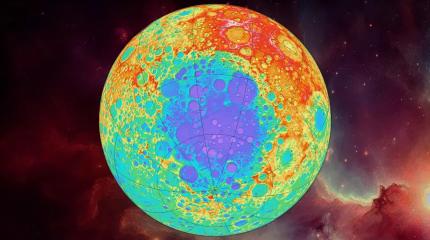

В самом большом кратере Луны происходит что-то очень странное

Поэтому астронавты планируют туда заглянуть в самое ближайшее время...

Секретные спутники Илона Маска заподозрили в использовании запрещенных сигналов

Что это значит для России и чем могут ответить наши военные?...

Археологи поражены: 404 тысячи лет назад «римляне» спокойно разделали гигантского слона... 3-сантиметровыми ножичками

Получается, что древние охотники могли справиться с самым большим животным в Европе буквально голыми руками?...

Ученые обнаружили на Кавказе «ужасного» хищника, способного дробить черепа с одного укуса

Почему же 400-килограммовый монстр, побеждавший медведей и саблезубых тигров, все-таки исчез с лица планеты?...

«Черный ящик» раскрыл тайну летучей мыши, пожирающей птиц прямо в полете

Ученые совершенно не ожидали, что рукокрылый властелин ночного неба по свирепости и охотничьему мастерству даст фору даже соколам...

Ученые выяснили: в каком возрасте наш мозг достигает пика своей активности

Почему же 20-30 лет оказались стереотипом, далеким от реальной жизни?...

2700 дней понадобилось ученым, чтобы, наконец, раскрыть главную тайну гигантских скатов

Оказалось, что манты ныряют на 1250-метровую глубину вовсе не за едой и не спасаясь от хищников...

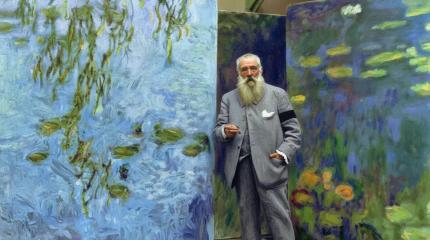

Мог ли великий художник Клод Моне видеть в ультрафиолетовом спектре, как пчела?

Историки уверены: после операции на глазах с французским живописцем стали происходит очень странные вещи...

В ближайшие 100 лет Юпитер «выстрелит» в Землю как минимум 342 раза

Российские ученые рассчитали: ближайшее «прицеливание» состоится уже 2031 году. Что вообще нам ожидать?...