Sophia: новый способ обучения больших языковых моделей

Команда из Стэнфордского университета создала новый способ предварительного обучения больших языковых моделей — программное обеспечение под названием Sophia, которое работает вдвое быстрее, чем существующие решения.

ChatGPT и другие приложения, использующие большие языковые модели (LLM), становятся все более популярными и привлекают много внимания со стороны СМИ. На текущий момент крупные технологические компании сильно преобладают над малыми на рынке LLM, и все это связано с дороговизной предварительного обучения языковых моделей. Стоимость может составлять от 10 миллионов долларов, а в некоторых случаях данная сумма увеличивается в десятки и сотни раз. Соответственно, для малых организаций или академических групп большие языковые модели на данный момент практически недоступны

Чтобы решить эту проблему, ученые решили улучшить существующие методы оптимизации LLM. Результатом стала разработка под названием Sophia, которая сокращает время предварительного обучения вдвое.

Чтобы оптимизировать предварительную подготовку LLM, разработчики использовали два метода.

Первый из них, известный как оценка кривизны, уже давно известен, но команда из Стэнфордского университета нашла способ сделать этот подход более эффективным. Суть метода заключается в оптимизации количества шагов, которые требуются для предварительного обучения, а также в правильном распределении нагрузки на каждом из этапов.

Такой шаг кажется очевидным в контексте рассматриваемого процесса, но, как ни странно, от него отказываются большинство компаний, занимающихся разработкой LLM. Дело в том, что оценка кривизны в техническом плане является дорогостоящей и сложной. Обычно оценка производится на каждом шаге оптимизации. Команда из Стэнфордского университета задалась вопросом: а можно ли сделать процесс более эффективным, уменьшив количество обновлений? Разработав оптимизатор Sophia, ученые добились своей цели — кривизна параметров стала оцениваться примерно каждые 10 шагов.

Второй метод команды, называемый отсечением, решает проблему, возникающую при использовании первого — неточную оценку кривизны. При отсечении устанавливается ограничение или пороговое значение для параметров модели. Если параметры превышают этот порог, их сложность считается неприемлемой, и модель не будет обрабатывать их. Таким образом предотвращаются ошибки или проблемы, возникающие из-за сложности, и улучшается эффективность обучения.

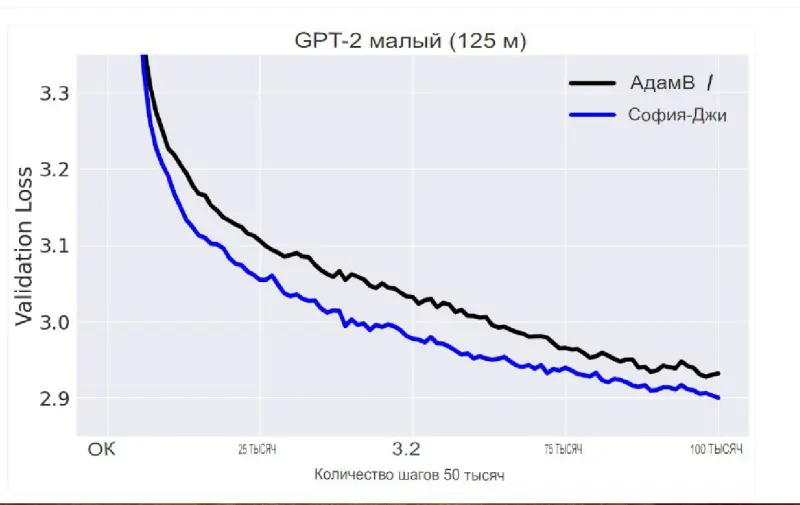

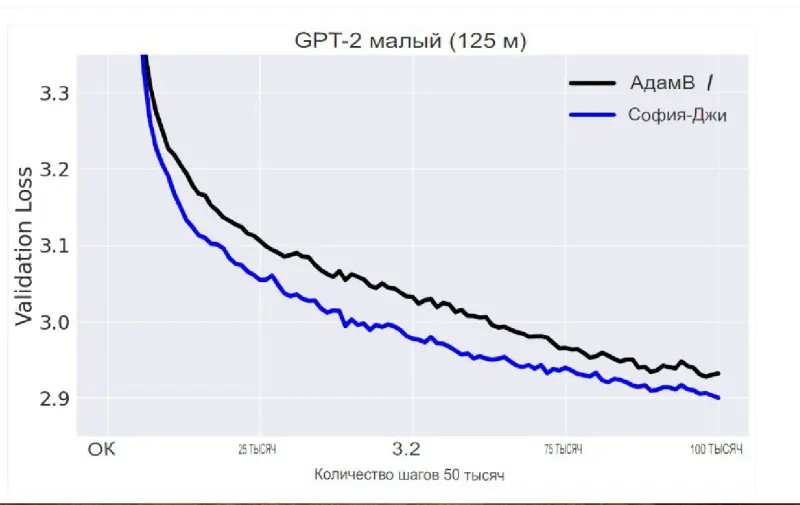

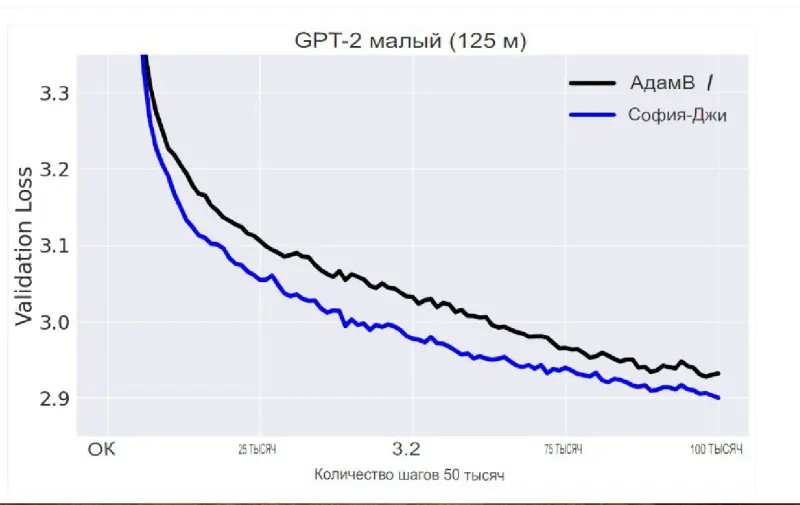

Разработчики использовали Sophia для предварительного обучения относительно небольшой модели LLM, используя те же размеры модели и конфигурацию, которые применялись при создании GPT-2.

В дальнейшем команда планирует разработать более крупную модель LLM с использованием Sophia. Ученые также надеются, что Sophia будет применяться и в других областях машинного обучения, таких как модели компьютерного зрения или мультимодальные модели.

— Гон Лю, аспирант компьютерных наук Стэнфордского университета.

ChatGPT и другие приложения, использующие большие языковые модели (LLM), становятся все более популярными и привлекают много внимания со стороны СМИ. На текущий момент крупные технологические компании сильно преобладают над малыми на рынке LLM, и все это связано с дороговизной предварительного обучения языковых моделей. Стоимость может составлять от 10 миллионов долларов, а в некоторых случаях данная сумма увеличивается в десятки и сотни раз. Соответственно, для малых организаций или академических групп большие языковые модели на данный момент практически недоступны

Чтобы решить эту проблему, ученые решили улучшить существующие методы оптимизации LLM. Результатом стала разработка под названием Sophia, которая сокращает время предварительного обучения вдвое.

Оптимизируя оптимизацию

Чтобы оптимизировать предварительную подготовку LLM, разработчики использовали два метода.

Первый из них, известный как оценка кривизны, уже давно известен, но команда из Стэнфордского университета нашла способ сделать этот подход более эффективным. Суть метода заключается в оптимизации количества шагов, которые требуются для предварительного обучения, а также в правильном распределении нагрузки на каждом из этапов.

Такой шаг кажется очевидным в контексте рассматриваемого процесса, но, как ни странно, от него отказываются большинство компаний, занимающихся разработкой LLM. Дело в том, что оценка кривизны в техническом плане является дорогостоящей и сложной. Обычно оценка производится на каждом шаге оптимизации. Команда из Стэнфордского университета задалась вопросом: а можно ли сделать процесс более эффективным, уменьшив количество обновлений? Разработав оптимизатор Sophia, ученые добились своей цели — кривизна параметров стала оцениваться примерно каждые 10 шагов.

Второй метод команды, называемый отсечением, решает проблему, возникающую при использовании первого — неточную оценку кривизны. При отсечении устанавливается ограничение или пороговое значение для параметров модели. Если параметры превышают этот порог, их сложность считается неприемлемой, и модель не будет обрабатывать их. Таким образом предотвращаются ошибки или проблемы, возникающие из-за сложности, и улучшается эффективность обучения.

Тестирование и масштабирование

Разработчики использовали Sophia для предварительного обучения относительно небольшой модели LLM, используя те же размеры модели и конфигурацию, которые применялись при создании GPT-2.

В дальнейшем команда планирует разработать более крупную модель LLM с использованием Sophia. Ученые также надеются, что Sophia будет применяться и в других областях машинного обучения, таких как модели компьютерного зрения или мультимодальные модели.

Использование Sophia для разработки новой большой языковой модели займет определенное время и достаточно много ресурсов, но так как она является программным обеспечением с открытым исходным кодом, сообщество, безусловно, может брать ее на вооружение

— Гон Лю, аспирант компьютерных наук Стэнфордского университета.

- Алексей Павлов

- arXiv preprint server

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Парадокс Великой Зеленой стены: Китай посадил 78 миллиардов новых деревьев, но климат стал только хуже. Как так вышло?

Ученые назвали причины, почему самый грандиозный экологический проект за всю историю в итоге обернулся головной болью для миллионов китайских граждан...

Марс отменяется: три причины, почему российские эксперты ставят крест на Красной планете

Почему пробирка с Марса опаснее любого астероида, как галактические лучи «взрывают» мозг и при чем тут Китай? Честный разбор рисков от Российской академии наук...

«Не повторяйте наших ошибок!» 100 лет борьбы с лесными пожарами обернулись катастрофой для США

Эксперты рассказали, почему, казалось бы, проверенная тактика только усугубила ситуацию с лесным огнем...

Темная сторона Рима: выяснилось, что Империя веками «выкачивала» здоровье из покоренных народов

Новые находки заставили ученых признать: для простых людей римский «прогресс» был скорее приговором, чем спасением. Но почему же так вышло?...

Мегамонстры с 7-го этажа: в древних океанах шла такая война хищников, где у современных косаток не было бы ни единого шанса

Ученые рассказали, куда исчезли «боги» мезозойских морей и почему сейчас их существование было бы невозможно...

ДНК 4000-летней овцы оказалось ключом к древней тайне, стоившей жизни миллионам

Поразительно, но археологи нашли штамм древней чумы, кошмаривший всю Евразию, в самом таинственном российском городе — Аркаиме. Почему же так получилось?...

Супертелескоп James Webb только запутал ученых, а планета-«близнец» Земли стала еще загадочнее

Эксперты рассказали, почему самый мощный телескоп в истории не смог разобраться с атмосферой TRAPPIST-1e. Аппарат не виноват. Но тогда кто?...

Встречи с неведомым: завершаем чтение дневников разведчика и писателя Владимира Арсеньева

Часть третья: таинственный огонь в лесу, свет из облаков, призрак в тумане и странный дым на море...

Первая «чернокожая британка» оказалась белой: новое исследование заставило историков полностью пересмотреть портрет женщины из Бичи-Хед

Почему ученые так сильно ошиблись с ее внешностью? И стоит ли после этого доверять реконструкциям по ДНК?...

Новое исследование показало: если бы не этот «российский ген», древние люди вряд ли бы заселили Америку

Ученые рассказали, почему Алтай в ДНК — это главный секрет феноменального здоровья индейцев...

Мощнее леса в десятки раз: в ЮАР нашли «живые камни», которые выкачивают CO₂ с бешеной скоростью

Микробиалиты могли бы спасти Землю от потепления, но у этих «каменных насосов» есть один нюанс...

20-летнее наблюдение со спутников «сломало климат»: Теперь ученым придется полностью менять все теории

Зато теперь понятно, почему в двух близких городах могут быть... разные времена года...

Грядет научный прорыв: Зачем в последние годы ученые по всему миру создают очень странные компьютеры?

Новые аппараты… не просто живые: они стирают различия между ЭВМ и человеческим мозгом...