Как победить ложь в интернете: новая функция Google «Об этом изображении»

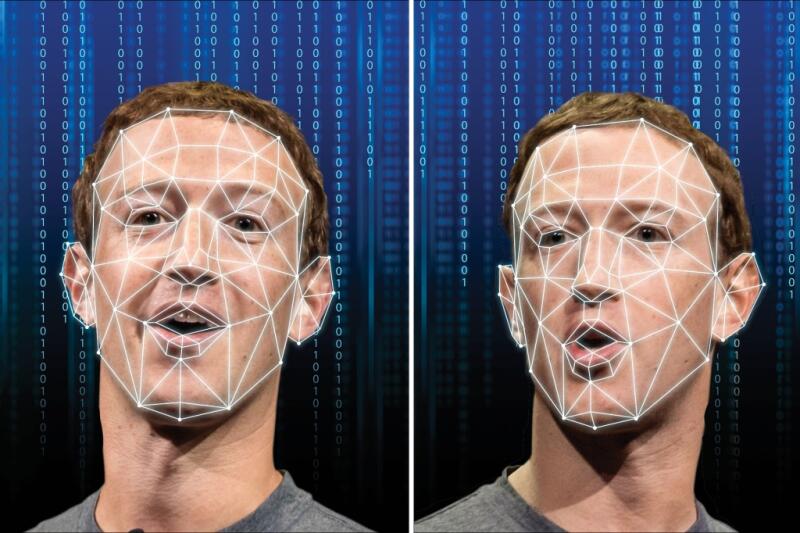

В современном интернете мы часто сталкиваемся с поддельными изображениями, которые могут обманывать нас или даже наносить вред. Особенно опасны дипфейки — это видео или фото, созданные с помощью искусственного интеллекта, которые подменяют лица, голоса или действия людей. Дипфейки могут влиять на наше мнение, эмоции и поведение, а также использоваться для целей дезинформации, шантажа, порнографии или политики.

Как же защитить себя от таких угроз? Компания Google разработала новую функцию «Об этом изображении», которая позволяет пользователям получать больше информации об изображениях, которые они видят в интернете. В этой статье мы расскажем, как эта функция работает, как она помогает распознавать дипфейки и какие еще технологии используются для борьбы с цифровой манипуляцией.

Дипфейки — это видео или фото, которые создаются с помощью искусственного интеллекта. Для этого используются специальные алгоритмы, которые называются генеративно-состязательными сетями (GAN). Эти сети состоят из двух нейронных сетей, которые соревнуются друг с другом: одна сеть генерирует поддельное изображение, а другая сеть пытается определить, насколько оно реалистично. Таким образом, сети постоянно учатся и улучшают свои результаты.

Дипфейки бывают разных видов: например, можно поменять лица людей на видео (face swap), изменить то, что они говорят (lip sync), скопировать их голос (voice cloning) или создать полностью синтетические лица и тела (digital avatars). С помощью дипфейков можно также «оживить» умерших людей или животных, как это было сделано с художником Сальвадором Дали или кошкой Лил Баб.

Дипфейки могут быть использованы не только для развлечения или искусства, но и для злых целей. В том числе для распространения дезинформации, шантажа, порнографии или политического вмешательства. Дипфейки могут заставить нас верить, что кто-то говорит или делает то, что он на самом деле не говорил или не делал.

Например, в ходе конфликта между Россией и Украиной в интернете появились дипфейки с президентами обеих стран, которые призывали своих солдат сдаться. Эти дипфейки были распространены через социальные сети и даже взломанные телеканалы. Хотя видеоролики были быстро опровергнуты и раскритикованы за низкое качество, они могли вызвать путаницу, недоверие и страх среди населения.

Другой пример — это дипфейк с бывшим президентом США Бараком Обамой, который якобы оскорблял своего преемника Дональда Трампа. Видео было создано известным комиком Джорданом Пилом и показано в телешоу. Хотя это был юмористический ролик, он также продемонстрировал потенциал дипфейков для подделки политических высказываний и компрометации лидеров.

Однако не все поддельные видео имеют юмористический или политический характер. Еще один пример — это поддельное видео с актрисой Галь Гадот, которая якобы снималась в порнофильме. Это видео было создано с помощью программы DeepFaceLab и размещено на сайте Pornhub. Хотя видео было удалено после жалоб, оно также показало возможность дипфейк-технологий.

Как видим, дипфейки могут нести разные опасности для общества и индивидов. Поэтому необходимо развивать критическое мышление, проверять информацию из разных источников и использовать специальные инструменты для обнаружения дипфейков. Также нужно разрабатывать законодательство и этические нормы для регулирования создания и распространения дипфейков.

Функция «Об этом изображении» позволит пользователям проверять достоверность и происхождение изображений, которые могут быть использованы для обмана или дезинформации.

В блоге Google объясняют, что эта функция предоставит три вида информации об изображениях в результатах поиска. Во-первых, она покажет, когда Google впервые проиндексировал изображение. Во-вторых, она укажет, где изображение было опубликовано в интернете впервые. В-третьих, она покажет, где изображение появлялось в других источниках, например, в социальных сетях, новостных сайтах или сайтах по проверке фактов.

— Google.

Поисковый гигант также добавил, что когда он запустит свои собственные генеративные инструменты искусственного интеллекта для создания изображений, они получат специальную разметку на случай распространения на других сайтах.

Как же защитить себя от таких угроз? Компания Google разработала новую функцию «Об этом изображении», которая позволяет пользователям получать больше информации об изображениях, которые они видят в интернете. В этой статье мы расскажем, как эта функция работает, как она помогает распознавать дипфейки и какие еще технологии используются для борьбы с цифровой манипуляцией.

Что такое дипфейки и как их создают?

Дипфейки — это видео или фото, которые создаются с помощью искусственного интеллекта. Для этого используются специальные алгоритмы, которые называются генеративно-состязательными сетями (GAN). Эти сети состоят из двух нейронных сетей, которые соревнуются друг с другом: одна сеть генерирует поддельное изображение, а другая сеть пытается определить, насколько оно реалистично. Таким образом, сети постоянно учатся и улучшают свои результаты.

Дипфейки бывают разных видов: например, можно поменять лица людей на видео (face swap), изменить то, что они говорят (lip sync), скопировать их голос (voice cloning) или создать полностью синтетические лица и тела (digital avatars). С помощью дипфейков можно также «оживить» умерших людей или животных, как это было сделано с художником Сальвадором Дали или кошкой Лил Баб.

Какие опасности несут дипфейки?

Дипфейки могут быть использованы не только для развлечения или искусства, но и для злых целей. В том числе для распространения дезинформации, шантажа, порнографии или политического вмешательства. Дипфейки могут заставить нас верить, что кто-то говорит или делает то, что он на самом деле не говорил или не делал.

Например, в ходе конфликта между Россией и Украиной в интернете появились дипфейки с президентами обеих стран, которые призывали своих солдат сдаться. Эти дипфейки были распространены через социальные сети и даже взломанные телеканалы. Хотя видеоролики были быстро опровергнуты и раскритикованы за низкое качество, они могли вызвать путаницу, недоверие и страх среди населения.

Другой пример — это дипфейк с бывшим президентом США Бараком Обамой, который якобы оскорблял своего преемника Дональда Трампа. Видео было создано известным комиком Джорданом Пилом и показано в телешоу. Хотя это был юмористический ролик, он также продемонстрировал потенциал дипфейков для подделки политических высказываний и компрометации лидеров.

Однако не все поддельные видео имеют юмористический или политический характер. Еще один пример — это поддельное видео с актрисой Галь Гадот, которая якобы снималась в порнофильме. Это видео было создано с помощью программы DeepFaceLab и размещено на сайте Pornhub. Хотя видео было удалено после жалоб, оно также показало возможность дипфейк-технологий.

Как видим, дипфейки могут нести разные опасности для общества и индивидов. Поэтому необходимо развивать критическое мышление, проверять информацию из разных источников и использовать специальные инструменты для обнаружения дипфейков. Также нужно разрабатывать законодательство и этические нормы для регулирования создания и распространения дипфейков.

Как новая функция Google поможет бороться с манипуляциями и ложью в интернете?

Функция «Об этом изображении» позволит пользователям проверять достоверность и происхождение изображений, которые могут быть использованы для обмана или дезинформации.

В блоге Google объясняют, что эта функция предоставит три вида информации об изображениях в результатах поиска. Во-первых, она покажет, когда Google впервые проиндексировал изображение. Во-вторых, она укажет, где изображение было опубликовано в интернете впервые. В-третьих, она покажет, где изображение появлялось в других источниках, например, в социальных сетях, новостных сайтах или сайтах по проверке фактов.

С этой дополнительной информацией об изображении вы сможете лучше оценить его надежность — или решить, что нужно провести дополнительную проверку. Например, с помощью «Об этом изображении» вы сможете узнать, что в новостных статьях сообщалось, что это изображение, демонстрирующее посадку на Луну поэтапно, было сгенерировано ИИ

— Google.

Поисковый гигант также добавил, что когда он запустит свои собственные генеративные инструменты искусственного интеллекта для создания изображений, они получат специальную разметку на случай распространения на других сайтах.

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Новое исследование показало: Стоунхендж столетиями «водил за нос». Похоже, историю опять придется переписывать

Оказалось, что сенсация скрывалась в огромном круге, состоящем из загадочных шахт...

Парадокс Великой Зеленой стены: Китай посадил 78 миллиардов новых деревьев, но климат стал только хуже. Как так вышло?

Ученые назвали причины, почему самый грандиозный экологический проект за всю историю в итоге обернулся головной болью для миллионов китайских граждан...

Людовик XIV умер совсем не от гангрены: ученые сумели раскрыть истину лишь 310 лет спустя

Эксперты говорят: французский король был обречен. Медикам того времени была совершенно неизвестна его болезнь...

Необъяснимые аномалии в тайге на Дальнем Востоке: читаем походные дневники военного разведчика и писателя Владимира Арсеньева

Часть первая: свет в ночном море, мираж «фата-моргана» и почти моментальное замерзание воды...

ЦРУ, море в пустыне и нефть: кто и зачем остановил проект Египта на 60 лет?

Часть вторая: Холодная война, 200 ядерных взрывов и 15 миллиардов, которые могут все изменить...

Меньше трех дней до конца света на орбите: почему программа CRASH Clock бьет тревогу?

Сотрудники Маска уверяют, что у них все под контролем. Но эксперты сравнивают орбиту с карточным домиком. Кто же прав?...

Что стоит за таинственными аномалиями в дальневосточной тайге? Продолжаем читать походные дневники военного разведчика и писателя Владимира Арсеньева

Часть вторая: снежная гроза, феномен моретрясения и встреча со «снежным человеком»...

Темная сторона Рима: выяснилось, что Империя веками «выкачивала» здоровье из покоренных народов

Новые находки заставили ученых признать: для простых людей римский «прогресс» был скорее приговором, чем спасением. Но почему же так вышло?...

Встречи с неведомым: завершаем чтение дневников разведчика и писателя Владимира Арсеньева

Часть третья: таинственный огонь в лесу, свет из облаков, призрак в тумане и странный дым на море...

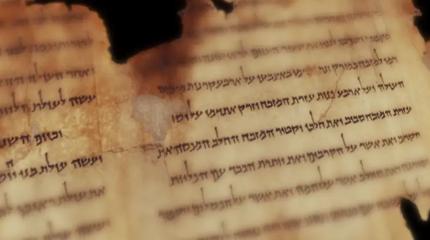

Загадочная письменность Б из пещер у Мертвого моря наконец-то расшифрована

Ученые «ломали» древний шифр эпохи Христа более 70 лет, но результат разочаровал многих. Почему?...

Первая «чернокожая британка» оказалась белой: новое исследование заставило историков полностью пересмотреть портрет женщины из Бичи-Хед

Почему ученые так сильно ошиблись с ее внешностью? И стоит ли после этого доверять реконструкциям по ДНК?...

Марс отменяется: три причины, почему российские эксперты ставят крест на Красной планете

Почему пробирка с Марса опаснее любого астероида, как галактические лучи «взрывают» мозг и при чем тут Китай? Честный разбор рисков от Российской академии наук...