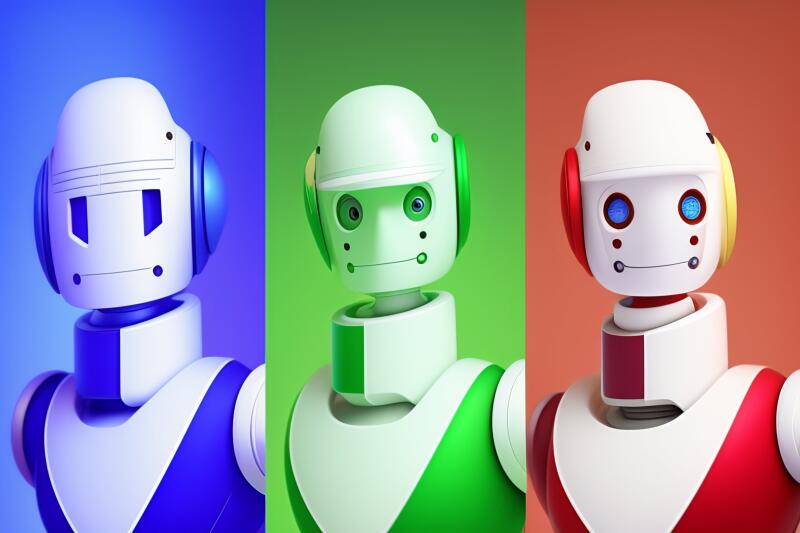

Чат Bing на базе искусственного интеллекта приобрел три «характера»

Сотрудник Microsoft Майк Дэвидсон объявил, что компания представила три отличительных стиля личности для своего экспериментального чат-бота Bing на базе искусственного интеллекта (ИИ): творческий, сбалансированный и точный. Microsoft тестирует эту функцию с 24 февраля на ограниченном круге пользователей. Переключение между режимами даёт разные результаты, которые меняют баланс между точностью и творческой составляющей, да, той самой креативностью.

Bing Chat — это помощник с поддержкой ИИ, основанный на усовершенствованной модели большого языка (LLM), разработанной компанией OpenAI. Ключевая особенность Bing Chat — способность выполнить поиск в интернете и включать результаты в свои ответы.

Microsoft анонсировала Bing Chat 7 февраля, и вскоре враждебные запросы регулярно приводили раннюю версию Bing Chat к симуляции безумия. Так пользователи обнаружили, что бота можно убедить угрожать им. Вскоре после этого Microsoft резко сократила всплески поведения Bing Chat, установив строгие ограничения на продолжительность разговоров.

С тех пор фирма экспериментирует со способами вернуть часть дерзкой индивидуальности Bing Chat для тех, кто этого хотел, но также позволяет другим пользователям искать более точные ответы. Это привело к появлению нового интерфейса «стиль разговора» с тремя вариантами выбора.

В экспериментах с тремя стилями журналисты издания ArsTechnica заметили, что «креативный» режим выдаёт более короткие и нестандартные предложения, которые не всегда безопасны или практичны. Точный режим допускал ошибки в сторону осторожности, иногда ничего не предлагая, если не видел безопасного способа достижения результата. В среднем режиме, сбалансированном, часто выдавались самые длинные ответы с самыми подробными результатами поиска и ссылками на веб-сайты в ответах.

С большими языковыми моделями неожиданные неточности (так называемые галлюцинации) часто учащаются с увеличением «креативности», что обычно означает, что модель ИИ будет больше отклоняться от информации, которую она изучила в своём наборе данных. Исследователи ИИ часто называют это свойство «температурой», но члены команды Bing говорят, что с новыми стилями общения происходит нечто большее.

По словам сотрудника Microsoft Михаила Парахина, переключение режимов в Bing Chat меняет фундаментальные аспекты поведения бота, в том числе переключение между различными моделями ИИ, которые прошли дополнительное обучение на основе человеческих ответов на его результаты. В разных режимах также используются разные начальные подсказки, а это означает, что Microsoft заменяет определяющую личность подсказку.

Хотя Bing Chat по-прежнему доступен только тем, кто зарегистрировался в списке ожидания, Microsoft продолжает совершенствовать его и другие функции поиска Bing на базе ИИ, готовясь к более широкому распространению среди пользователей. Недавно Microsoft объявила о планах по интеграции технологии в Windows 11.

Bing Chat — это помощник с поддержкой ИИ, основанный на усовершенствованной модели большого языка (LLM), разработанной компанией OpenAI. Ключевая особенность Bing Chat — способность выполнить поиск в интернете и включать результаты в свои ответы.

Microsoft анонсировала Bing Chat 7 февраля, и вскоре враждебные запросы регулярно приводили раннюю версию Bing Chat к симуляции безумия. Так пользователи обнаружили, что бота можно убедить угрожать им. Вскоре после этого Microsoft резко сократила всплески поведения Bing Chat, установив строгие ограничения на продолжительность разговоров.

С тех пор фирма экспериментирует со способами вернуть часть дерзкой индивидуальности Bing Chat для тех, кто этого хотел, но также позволяет другим пользователям искать более точные ответы. Это привело к появлению нового интерфейса «стиль разговора» с тремя вариантами выбора.

В экспериментах с тремя стилями журналисты издания ArsTechnica заметили, что «креативный» режим выдаёт более короткие и нестандартные предложения, которые не всегда безопасны или практичны. Точный режим допускал ошибки в сторону осторожности, иногда ничего не предлагая, если не видел безопасного способа достижения результата. В среднем режиме, сбалансированном, часто выдавались самые длинные ответы с самыми подробными результатами поиска и ссылками на веб-сайты в ответах.

С большими языковыми моделями неожиданные неточности (так называемые галлюцинации) часто учащаются с увеличением «креативности», что обычно означает, что модель ИИ будет больше отклоняться от информации, которую она изучила в своём наборе данных. Исследователи ИИ часто называют это свойство «температурой», но члены команды Bing говорят, что с новыми стилями общения происходит нечто большее.

По словам сотрудника Microsoft Михаила Парахина, переключение режимов в Bing Chat меняет фундаментальные аспекты поведения бота, в том числе переключение между различными моделями ИИ, которые прошли дополнительное обучение на основе человеческих ответов на его результаты. В разных режимах также используются разные начальные подсказки, а это означает, что Microsoft заменяет определяющую личность подсказку.

Хотя Bing Chat по-прежнему доступен только тем, кто зарегистрировался в списке ожидания, Microsoft продолжает совершенствовать его и другие функции поиска Bing на базе ИИ, готовясь к более широкому распространению среди пользователей. Недавно Microsoft объявила о планах по интеграции технологии в Windows 11.

- Дмитрий Ладыгин

- lexica.art

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Операция «Байконур»: как СССР дерзко и красиво долгие годы водил за нос весь Запад

С какого космодрома на самом деле стартовал Юрий Гагарин?...

Темная тайна муслиновой «эпидемии»: почему иностранная ткань выкосила тысячи красивых молодых женщин в России начала XIX века?

«Барыни гибнут тысячами как осенние мухи»: на 20 лет французская мода «отключила» инстинкт самосохранения у русских аристократок...

Рассекреченные архивы ФСБ полностью подтвердили легенду о медали № 00001 «За оборону Сталинграда»

Историки рассказали: почему Сталин пришел в гнев, когда ему попытались вручить эту награду...

11 лет обмана и позора: Эксперты констатируют, что программа «Чистый Эверест» с треском провалилась

Кто и почему превращает высочайшую гору на планете в гигантскую свалку?...

Главная тайна Аркаима: что спасло самый древний город на территории России от полного уничтожения?

Почему эксперты считают, что в этом месте «текут» две параллельные реальности?...

Новое исследование показало: «пришельцы» правят дном арктических морей вот уже полмиллиарда лет

Российские ученые сделали поразительное открытие, изучив 3000 находок за последние 80 лет...

Еще раз о Карамзине: почему нынешние ученые обвиняют его в многочисленных и сознательных искажениях российской истории?

Зачем «великий историк» XIX века так очернил Ивана Грозного?...

Чужое сердце, чужая жизнь: эти истории заставляют сомневаться в науке

Новое исследование говорит: 90% людей, получивших чужие органы, признаются, что они странно изменились после операции...

Наука в корне ошибалась: на Титане нет огромного океана, вместо этого он пронизан «слякотными туннелями»

Почему ученые уверены, что новое открытие только увеличивает шансы на нахождение жизни на крупнейшем спутнике Сатурна?...

«Криминальный авторитет» мезозойской эпохи: российские ученые обнаружили динозавра, который был «заточен» исключительно… под воровство

Грабил по ночам, таскал яйца у гигантов и много миллионов лет оставался нераскрытым...