Ишь чего удумал: ИИ от OpenAI иногда вдруг «рассуждает» на китайском языке

В сентябре 2024-го компания OpenAI выпустила генеративную модель искусственного интеллекта o1. Новинка отличается от предыдущей фирменной модели GPT-4o способностью «рассуждать», подобно человеку, и решать более сложные задачи.

Поясним, что модель искусственного интеллекта (ИИ) — это компьютерная программа, служащая для имитации умственных способностей человека, в том или ином их аспекте.

Однако незамутнённый энтузиазм поклонников вскоре стал сменяться изумлением. Пользователи вдруг начали наблюдать нечто обескураживающее. Модель иногда принималась «думать» на китайском, реже фарси или ещё каком-нибудь ином языке, даже если перед ней ставили вопрос на языке Шекспира.

Получив запрос, например, о том, сколько букв r в определённом слове, o1 начнёт «думать» и выдаст ответ после логических шагов. Если вопрос был задан на английском языке, то и ответ модели ИИ должен последовать на нём же. Но прежде чем прийти к выводу, она выполнит несколько шагов на другом языке.

Так, один пользователь сообщил в соцсети Reddit, что o1 начал «думать» в процессе на китайском. Другой пользователь рассказал в соцсети X, что при общении с o1 эта модель ИИ вдруг начала выдавать китайский текст. Это произошло внезапно, и ничего, казалось бы, подобного не провоцировало.

Представители компании OpenAI не предоставили никаких объяснений по поводу странного поведения o1. Что же могло произойти? Эксперты в сфере ИИ не уверены в причинах происходящего. Но у них есть несколько теорий.

Некоторые специалисты, в том числе Клеман Деланж, гендиректор платформы для разработки и распространения ИИ-инструментов Hugging Face, указывали на тот факт, что модели ИИ обучают на комплексах данных, среди которых — множество иероглифов родом из Поднебесной.

Тед Сяо из компании Google DeepMind объяснил, что в OpenAI (и не только она) привлекают сервисы со стороны для обработки китайских данных. Он сказал, что внезапные переходы o1 на китайский — это пример влияния языка на «рассуждения». Причина — в обстановке на рынке труда.

— Сяо.

Специальные метки (они же теги или аннотации) содействуют моделям ИИ в восприятии информации в процессе обучения. Так, метки помогают той же модели распознавания изображений «складировать в память» объекты, относящиеся к тому или иному человеку, месту или предмету на картинке.

Исследования уже доказали, что конкретные метки могут приводить к неожиданному поведению моделей. Например, аннотатор (составитель примечаний) может вписывать фразы на сленге с неформальной грамматикой. А когда слова приобретают нестандартные оттенки смысла, всё идёт наперекосяк.

Однако остальных экспертов не убедила гипотеза о том, что o1 усвоил исключительно китайские данные. Они отметили, что при поиске решения o1 с такой же вероятностью может переключиться на любой другой язык: хинди, тайский и так далее. Видимо, o1 и другие модели ИИ способны применять языки, которые сочтут по каким-то своим «соображениям» наиболее подходящими в тот или иной момент. А с точки зрения человека — попросту галлюцинировать, то есть бредить.

— Мэтью Гуздиал, эксперт по ИИ из Университета Альберты

В действительности модели не обрабатывают слова непосредственно. Вместо этого они используют токены, которые могут быть и словами, и слогами, и даже отдельными буквами либо иероглифами.

Как и примечания, токены могут провоцировать ошибки. Например, многие программы по интерпретации слов в токены подразумевают, что пробел обозначает ещё одно слово, хотя не во всех языках слова разделяются пробелами.

Тичжэнь Ван, программист из ИИ-стартапа Hugging Face, солидарен с Гуздиалом в том, что языковые нестыковки в «рассуждениях» моделей можно объяснить возникшими при обучении смысловыми связями.

— Ван.

Теория Вана убедительна, поскольку модели работают на основе вероятностей. Натренированные на изобилии примеров, они усваивают закономерности, чтобы прогнозировать, например, что после «кого» в электронном сообщении обычно следует «это может касаться».

Но Лука Сольдайни, научный сотрудник некоммерческого Института ИИ Аллена, предупредил, что нет оснований для определённости. Журналистам издания TechCrunch эксперт сказал, что нельзя утверждать то или иное из-за нехватки информации о том, как обучают модели ИИ.

— Сольдайни.

Поскольку в OpenAI не комментируют удивительные сбои, остаётся только догадываться, почему o1 «рассуждает» о песнях на французском, но о биологии — на китайском.

Поясним, что модель искусственного интеллекта (ИИ) — это компьютерная программа, служащая для имитации умственных способностей человека, в том или ином их аспекте.

Однако незамутнённый энтузиазм поклонников вскоре стал сменяться изумлением. Пользователи вдруг начали наблюдать нечто обескураживающее. Модель иногда принималась «думать» на китайском, реже фарси или ещё каком-нибудь ином языке, даже если перед ней ставили вопрос на языке Шекспира.

Получив запрос, например, о том, сколько букв r в определённом слове, o1 начнёт «думать» и выдаст ответ после логических шагов. Если вопрос был задан на английском языке, то и ответ модели ИИ должен последовать на нём же. Но прежде чем прийти к выводу, она выполнит несколько шагов на другом языке.

Так, один пользователь сообщил в соцсети Reddit, что o1 начал «думать» в процессе на китайском. Другой пользователь рассказал в соцсети X, что при общении с o1 эта модель ИИ вдруг начала выдавать китайский текст. Это произошло внезапно, и ничего, казалось бы, подобного не провоцировало.

Представители компании OpenAI не предоставили никаких объяснений по поводу странного поведения o1. Что же могло произойти? Эксперты в сфере ИИ не уверены в причинах происходящего. Но у них есть несколько теорий.

Некоторые специалисты, в том числе Клеман Деланж, гендиректор платформы для разработки и распространения ИИ-инструментов Hugging Face, указывали на тот факт, что модели ИИ обучают на комплексах данных, среди которых — множество иероглифов родом из Поднебесной.

Тед Сяо из компании Google DeepMind объяснил, что в OpenAI (и не только она) привлекают сервисы со стороны для обработки китайских данных. Он сказал, что внезапные переходы o1 на китайский — это пример влияния языка на «рассуждения». Причина — в обстановке на рынке труда.

Такие разработчики, как OpenAI и Anthropic, используют подрядчиков ради данных для математики и программирования. Из-за дефицита специалистов и дороговизны их услуг многие сотрудники — из Китая

— Сяо.

Специальные метки (они же теги или аннотации) содействуют моделям ИИ в восприятии информации в процессе обучения. Так, метки помогают той же модели распознавания изображений «складировать в память» объекты, относящиеся к тому или иному человеку, месту или предмету на картинке.

Исследования уже доказали, что конкретные метки могут приводить к неожиданному поведению моделей. Например, аннотатор (составитель примечаний) может вписывать фразы на сленге с неформальной грамматикой. А когда слова приобретают нестандартные оттенки смысла, всё идёт наперекосяк.

Однако остальных экспертов не убедила гипотеза о том, что o1 усвоил исключительно китайские данные. Они отметили, что при поиске решения o1 с такой же вероятностью может переключиться на любой другой язык: хинди, тайский и так далее. Видимо, o1 и другие модели ИИ способны применять языки, которые сочтут по каким-то своим «соображениям» наиболее подходящими в тот или иной момент. А с точки зрения человека — попросту галлюцинировать, то есть бредить.

Модель ИИ не «осознаёт», что такое языки по отдельности, сами по себе. Для неё это просто текст

— Мэтью Гуздиал, эксперт по ИИ из Университета Альберты

В действительности модели не обрабатывают слова непосредственно. Вместо этого они используют токены, которые могут быть и словами, и слогами, и даже отдельными буквами либо иероглифами.

Как и примечания, токены могут провоцировать ошибки. Например, многие программы по интерпретации слов в токены подразумевают, что пробел обозначает ещё одно слово, хотя не во всех языках слова разделяются пробелами.

Тичжэнь Ван, программист из ИИ-стартапа Hugging Face, солидарен с Гуздиалом в том, что языковые нестыковки в «рассуждениях» моделей можно объяснить возникшими при обучении смысловыми связями.

Так, для меня удобнее заниматься математикой на китайском, где одна цифра — это один слог, отчего вычисления выглядят более ясными. Но когда дело касается неосознанных предубеждений, я машинально переключаюсь на английский, ведь на нём я впервые узнал и усвоил соответствующие идеи

— Ван.

Теория Вана убедительна, поскольку модели работают на основе вероятностей. Натренированные на изобилии примеров, они усваивают закономерности, чтобы прогнозировать, например, что после «кого» в электронном сообщении обычно следует «это может касаться».

Но Лука Сольдайни, научный сотрудник некоммерческого Института ИИ Аллена, предупредил, что нет оснований для определённости. Журналистам издания TechCrunch эксперт сказал, что нельзя утверждать то или иное из-за нехватки информации о том, как обучают модели ИИ.

Это один из многих примеров того, почему прозрачность в построении систем искусственного интеллекта имеет фундаментальное значение

— Сольдайни.

Поскольку в OpenAI не комментируют удивительные сбои, остаётся только догадываться, почему o1 «рассуждает» о песнях на французском, но о биологии — на китайском.

- Дмитрий Ладыгин

- shedevrum.ai; t.me/kandinsky21_bot

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Тайна необъяснимых северных кратеров разгадана спустя 11 лет после появления первого провала на Ямале

Почему российские ученые не рады своему открытию, называя его «русской рулеткой»?...

Генетики вычислили, какую страшную цену заплатили наши предки за высокий интеллект

Новое исследование еще раз доказало, что эволюция требует огромных жертв...

Секретная база в Гренландии, спрятанная 30-метровым слоем льда, угрожает всему миру

Гляциолог Уильям Колган говорит: «Американские военные думали, что это никогда не вскроется, но теперь...»...

Рядом с пирамидами Гизы обнаружены секретные тоннели, ведущие в забытый подземный мир

Быть может, их построили даже не египтяне. Но кто тогда?...

Наше тело — это… большой мозг: эксперимент русского ученого может совершить революцию в медицине

Эксперты говорят: «Открытие клеточной памяти — это огромный шаг к медицине, где лечение будет подбираться точно для конкретного человека»...

В Антарктиде обнаружен метановый «спящий гигант», который очень быстро просыпается. И это плохая новость

Ученые в тревоге задаются вопросом: означают ли десятки газовых гейзеров под водой, что эффект домино уже запущен?...

Почему на космическое ноу-хау «солнечный свет по запросу» ополчились астрономы всего мира?

Американский стартап обещает, что все будет хорошо, но ему никто не верит...

Ученые выяснили: в каком возрасте наш мозг достигает пика своей активности

Почему же 20-30 лет оказались стереотипом, далеким от реальной жизни?...

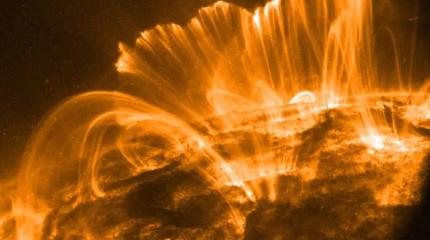

Астрофизики Гавайского университета неожиданно разгадали тайну… солнечного дождя

Рассказываем, почему новое открытие важно для каждого жителя Земли...

Как мадагаскарские лемуры ускоряют покорение космоса?

И почему именно эти животные оказались самые ценными для будущего всего человечества?...

Турецкие археологи обнаружили затерянный мост, способный переписать всю раннюю историю человечества

Оказалось, что научная сенсация все это время... валялась у ученых буквально под ногами...

В самом большом кратере Луны происходит что-то очень странное

Поэтому астронавты планируют туда заглянуть в самое ближайшее время...