Ученые используют особенности нашего мозга, чтобы сделать ИИ более надежным

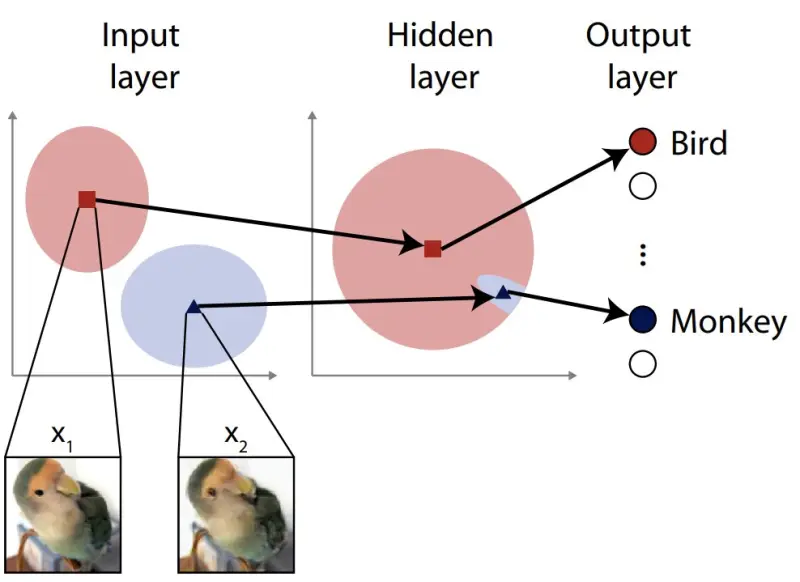

Большинство систем искусственного интеллекта основаны на нейронных сетях — алгоритмах, вдохновленных биологическими нейронами. Эти сети могут состоять из нескольких слоев: входные данные поступают с одной стороны, а выходные — с другой. Выходные данные можно использовать для принятия автоматических решений, например, в беспилотных автомобилях.

Атаки с целью ввести в заблуждение нейронную сеть могут включать использование уязвимостей во входных слоях, но обычно при разработке защиты учитывается только начальный входной уровень. Впервые исследователи дополнили внутренние слои нейронной сети процессом, включающим случайный шум, чтобы повысить ее устойчивость.

Искусственный интеллект (ИИ) стал относительно обычным явлением. Наверняка у вас есть смартфон с ИИ или вы используете поисковую систему на базе него. Хотя это широкий термин, который может включать множество различных способов обработки информации и иногда принятия решений, системы ИИ часто строятся с использованием искусственных нейронных сетей (ИНС), аналогичных сетям мозга.

И, как и мозг, ИНС иногда могут запутываться либо случайно, либо в результате преднамеренных действий третьей стороны. Такой процесс у нейросети схож с результатом оптической иллюзии у человека: может возникнуть ощущение, что вы смотрите на одну вещь, хотя на самом деле изображена другая.

Однако разница между тем, что сбивает с толку ИНС, и вещами, путающими нас, заключается в том, что некоторые визуальные данные могут казаться совершенно нормальными или, по крайней мере, понятными для нас, но ИНС «увидит» в этом нечто иное.

Тривиальным примером может послужить система классификации изображений, принявшая кошку за собаку. Но более серьезная ситуация возникает с беспилотным автомобилем, ошибочно принимающим знак остановки за знак, дающий право проезда. На данный момент существуют медицинские диагностические системы и многие другие специальные подходы, которые принимают входные данные и информируют или даже принимают решения, которые могут повлиять на людей.

Поскольку входные данные не обязательно являются визуальными, не всегда легко с первого взгляда проанализировать, почему система могла допустить ошибку. Злоумышленники, пытающиеся разрушить алгоритм, основанный на ИНС, могут воспользоваться этим, незаметно изменив ожидаемый шаблон ввода так, что он будет неправильно истолкован, и система будет вести себя некорректно.

Существуют некоторые методы защиты от подобных атак, но они имеют ряд недостатков. Недавний выпускник Дзюмпей Укита и профессор Кеничи Оки с кафедры физиологии Высшей медицинской школы Токийского университета разработали и протестировали новый способ улучшения защиты ИНС.

— Кеничи Оки, профессор с кафедры физиологии Высшей медицинской школы Токийского университета.

Дзюмпей Укита и Кеничи Оки не просто ученые компьютерных наук. Они также изучали человеческий мозг, и это вдохновило их использовать известный им феномен в ИНС. Они предложили добавить шум не только к входному слою, но и к более глубоким. Обычно этого избегают, поскольку есть опасения, что это повлияет на эффективность сети. Но исследователи выяснили, что это не так, и вместо этого шум способствовал большей адаптивности их тестовой ИНС, что снизило ее восприимчивость к моделируемым атакам.

— Дзюмпей Укита, выпускник кафедры физиологии Высшей медицинской школы Токийского университета.

Хотя новая идея действительно надежна, команда хочет развивать ее дальше, чтобы сделать систему еще более эффективной против ожидаемых атак, в том числе тех, против которых защиту еще не проверяли.

— Дзюмпей Укита.

Атаки с целью ввести в заблуждение нейронную сеть могут включать использование уязвимостей во входных слоях, но обычно при разработке защиты учитывается только начальный входной уровень. Впервые исследователи дополнили внутренние слои нейронной сети процессом, включающим случайный шум, чтобы повысить ее устойчивость.

Искусственный интеллект (ИИ) стал относительно обычным явлением. Наверняка у вас есть смартфон с ИИ или вы используете поисковую систему на базе него. Хотя это широкий термин, который может включать множество различных способов обработки информации и иногда принятия решений, системы ИИ часто строятся с использованием искусственных нейронных сетей (ИНС), аналогичных сетям мозга.

И, как и мозг, ИНС иногда могут запутываться либо случайно, либо в результате преднамеренных действий третьей стороны. Такой процесс у нейросети схож с результатом оптической иллюзии у человека: может возникнуть ощущение, что вы смотрите на одну вещь, хотя на самом деле изображена другая.

Однако разница между тем, что сбивает с толку ИНС, и вещами, путающими нас, заключается в том, что некоторые визуальные данные могут казаться совершенно нормальными или, по крайней мере, понятными для нас, но ИНС «увидит» в этом нечто иное.

Тривиальным примером может послужить система классификации изображений, принявшая кошку за собаку. Но более серьезная ситуация возникает с беспилотным автомобилем, ошибочно принимающим знак остановки за знак, дающий право проезда. На данный момент существуют медицинские диагностические системы и многие другие специальные подходы, которые принимают входные данные и информируют или даже принимают решения, которые могут повлиять на людей.

Поскольку входные данные не обязательно являются визуальными, не всегда легко с первого взгляда проанализировать, почему система могла допустить ошибку. Злоумышленники, пытающиеся разрушить алгоритм, основанный на ИНС, могут воспользоваться этим, незаметно изменив ожидаемый шаблон ввода так, что он будет неправильно истолкован, и система будет вести себя некорректно.

Ученые предлагают новый вариант защиты от атак

Существуют некоторые методы защиты от подобных атак, но они имеют ряд недостатков. Недавний выпускник Дзюмпей Укита и профессор Кеничи Оки с кафедры физиологии Высшей медицинской школы Токийского университета разработали и протестировали новый способ улучшения защиты ИНС.

Нейронные сети обычно состоят из слоев виртуальных нейронов. Первые слои часто отвечают за анализ входных данных путем идентификации элементов, соответствующих им.

Злоумышленник может спрятать в изображении артефакты, которые заставят сеть неправильно его классифицировать. Защитой от такой атаки может быть намеренное введение некоторого шума в этот первый уровень. На первый взгляд нелогично, что такой метод может помочь, но на деле мы позволяем лучше адаптироваться к изображению или другому набору входных данных. Однако этот метод не всегда эффективен, и мы подумали, что можем улучшить его, заглянув за пределы входного слоя — глубже в сеть.

Злоумышленник может спрятать в изображении артефакты, которые заставят сеть неправильно его классифицировать. Защитой от такой атаки может быть намеренное введение некоторого шума в этот первый уровень. На первый взгляд нелогично, что такой метод может помочь, но на деле мы позволяем лучше адаптироваться к изображению или другому набору входных данных. Однако этот метод не всегда эффективен, и мы подумали, что можем улучшить его, заглянув за пределы входного слоя — глубже в сеть.

— Кеничи Оки, профессор с кафедры физиологии Высшей медицинской школы Токийского университета.

Дзюмпей Укита и Кеничи Оки не просто ученые компьютерных наук. Они также изучали человеческий мозг, и это вдохновило их использовать известный им феномен в ИНС. Они предложили добавить шум не только к входному слою, но и к более глубоким. Обычно этого избегают, поскольку есть опасения, что это повлияет на эффективность сети. Но исследователи выяснили, что это не так, и вместо этого шум способствовал большей адаптивности их тестовой ИНС, что снизило ее восприимчивость к моделируемым атакам.

Нашим первым шагом была разработка гипотетического метода атаки, который проходит глубже входного уровня. Такая атака должна была бы противостоять устойчивости сети со стандартной защитой на ее входном уровне.

Такие атаки работают, намеренно предоставляя входные данные далеко от тех, которые ИНС может правильно классифицировать, а не рядом с ними. Но хитрость заключается в том, чтобы вместо этого включить слегка вводящие в заблуждение артефакты на более глубокие уровни. Однажды мы продемонстрировали опасность такой атаки — ввели случайный шум в более глубокие скрытые слои сети, чтобы повысить их адаптивность и, следовательно, возможности защиты. Мы рады сообщить, что это работает.

Такие атаки работают, намеренно предоставляя входные данные далеко от тех, которые ИНС может правильно классифицировать, а не рядом с ними. Но хитрость заключается в том, чтобы вместо этого включить слегка вводящие в заблуждение артефакты на более глубокие уровни. Однажды мы продемонстрировали опасность такой атаки — ввели случайный шум в более глубокие скрытые слои сети, чтобы повысить их адаптивность и, следовательно, возможности защиты. Мы рады сообщить, что это работает.

— Дзюмпей Укита, выпускник кафедры физиологии Высшей медицинской школы Токийского университета.

Хотя новая идея действительно надежна, команда хочет развивать ее дальше, чтобы сделать систему еще более эффективной против ожидаемых атак, в том числе тех, против которых защиту еще не проверяли.

В будущем злоумышленники могут попытаться рассмотреть возможность атак, способных избежать шума в пространстве функций, что мы и рассматривали в этом исследовании. Нападение и защита — это две стороны одной медали, это гонка вооружений, от которой ни одна из сторон не отступит, поэтому нам необходимо постоянно находить, совершенствовать и внедрять новые идеи, чтобы защитить системы, которые мы используем каждый день.

— Дзюмпей Укита.

- Алексей Павлов

- Ohki & Ukita CC-BY

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Парадокс Великой Зеленой стены: Китай посадил 78 миллиардов новых деревьев, но климат стал только хуже. Как так вышло?

Ученые назвали причины, почему самый грандиозный экологический проект за всю историю в итоге обернулся головной болью для миллионов китайских граждан...

Марс отменяется: три причины, почему российские эксперты ставят крест на Красной планете

Почему пробирка с Марса опаснее любого астероида, как галактические лучи «взрывают» мозг и при чем тут Китай? Честный разбор рисков от Российской академии наук...

«Не повторяйте наших ошибок!» 100 лет борьбы с лесными пожарами обернулись катастрофой для США

Эксперты рассказали, почему, казалось бы, проверенная тактика только усугубила ситуацию с лесным огнем...

Темная сторона Рима: выяснилось, что Империя веками «выкачивала» здоровье из покоренных народов

Новые находки заставили ученых признать: для простых людей римский «прогресс» был скорее приговором, чем спасением. Но почему же так вышло?...

Мегамонстры с 7-го этажа: в древних океанах шла такая война хищников, где у современных косаток не было бы ни единого шанса

Ученые рассказали, куда исчезли «боги» мезозойских морей и почему сейчас их существование было бы невозможно...

ДНК 4000-летней овцы оказалось ключом к древней тайне, стоившей жизни миллионам

Поразительно, но археологи нашли штамм древней чумы, кошмаривший всю Евразию, в самом таинственном российском городе — Аркаиме. Почему же так получилось?...

Супертелескоп James Webb только запутал ученых, а планета-«близнец» Земли стала еще загадочнее

Эксперты рассказали, почему самый мощный телескоп в истории не смог разобраться с атмосферой TRAPPIST-1e. Аппарат не виноват. Но тогда кто?...

Новое исследование показало: если бы не этот «российский ген», древние люди вряд ли бы заселили Америку

Ученые рассказали, почему Алтай в ДНК — это главный секрет феноменального здоровья индейцев...

Первая «чернокожая британка» оказалась белой: новое исследование заставило историков полностью пересмотреть портрет женщины из Бичи-Хед

Почему ученые так сильно ошиблись с ее внешностью? И стоит ли после этого доверять реконструкциям по ДНК?...

Мощнее леса в десятки раз: в ЮАР нашли «живые камни», которые выкачивают CO₂ с бешеной скоростью

Микробиалиты могли бы спасти Землю от потепления, но у этих «каменных насосов» есть один нюанс...

20-летнее наблюдение со спутников «сломало климат»: Теперь ученым придется полностью менять все теории

Зато теперь понятно, почему в двух близких городах могут быть... разные времена года...

Грядет научный прорыв: Зачем в последние годы ученые по всему миру создают очень странные компьютеры?

Новые аппараты… не просто живые: они стирают различия между ЭВМ и человеческим мозгом...