Этичность и дезинформация: эксперты обсудили проблемы, возникающие при работе с большими языковыми моделями

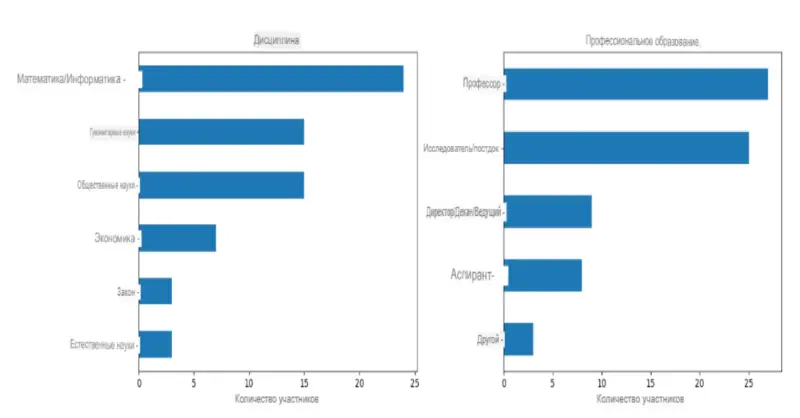

Большие языковые модели (Large Language Model, LLM), используемые, в том числе, в ChatGPT, способны произвести революцию в науке. Таков вывод исследования, проведенного институтом Александра фон Гумбольдта. В нём приняли участие 72 международных эксперта, специализирующихся в области искусственного интеллекта и цифровизации.

Респонденты отмечают, что положительное влияние LLM на научную среду сильно перевешивает негативное. В то же время они подчеркивают важность принятия мер по борьбе с возможной дезинформацией со стороны LLM, чтобы сохранить доверие к научным исследованиям. Поэтому они призывают к регулированию, прозрачности и новым этическим стандартам использования генеративного ИИ.

По мнению респондентов, LLM способны генерировать ложные научные утверждения, которые на первый взгляд неотличимы от подлинных результатов исследований. Эта дезинформация может озвучиваться в публичных дебатах и влиять на политические решения, оказывая негативное влияние на общество. Точно так же ложные данные из больших языковых моделей могут включать в создаваемые тексты различные расистские и дискриминационные стереотипы. Эти ошибки могут проникнуть в научные дебаты, если исследователи будут включать контент, созданный LLM, в свою повседневную работу без тщательной проверки.

Чтобы преодолеть эти проблемы, исследователи должны уметь критически относиться к работе LLM. Из-за увеличения количества дезинформации учёным необходимо использовать свой опыт, авторитет и репутацию для продвижения объективного публичного дискурса. Они должны выступать за более строгие правовые нормы, повышение прозрачности данных обучения, а также за культивирование ответственных и этичных методов использования генеративного ИИ в науке.

По мнению экспертов, положительный эффект наиболее заметен в текстовой части академической работы. В будущем большие языковые модели повысят эффективность исследований за счет автоматизации различных задач, связанных с написанием и публикацией статей. Точно так же они могут избавить ученых от растущей административной отчетности.

В результате такой помощи освобождается время для дальнейших инноваций, так как исследователи смогут уделить основное внимание на содержание своих исследований и при этом эффективно донести его до более широкой аудитории.

— Доктор Бенедикт Фехер, автор исследования «Друг или враг? Изучение влияния больших языковых моделей на науку».

Респонденты отмечают, что положительное влияние LLM на научную среду сильно перевешивает негативное. В то же время они подчеркивают важность принятия мер по борьбе с возможной дезинформацией со стороны LLM, чтобы сохранить доверие к научным исследованиям. Поэтому они призывают к регулированию, прозрачности и новым этическим стандартам использования генеративного ИИ.

Генерация лжи

По мнению респондентов, LLM способны генерировать ложные научные утверждения, которые на первый взгляд неотличимы от подлинных результатов исследований. Эта дезинформация может озвучиваться в публичных дебатах и влиять на политические решения, оказывая негативное влияние на общество. Точно так же ложные данные из больших языковых моделей могут включать в создаваемые тексты различные расистские и дискриминационные стереотипы. Эти ошибки могут проникнуть в научные дебаты, если исследователи будут включать контент, созданный LLM, в свою повседневную работу без тщательной проверки.

Чтобы преодолеть эти проблемы, исследователи должны уметь критически относиться к работе LLM. Из-за увеличения количества дезинформации учёным необходимо использовать свой опыт, авторитет и репутацию для продвижения объективного публичного дискурса. Они должны выступать за более строгие правовые нормы, повышение прозрачности данных обучения, а также за культивирование ответственных и этичных методов использования генеративного ИИ в науке.

Союзник или враг?

По мнению экспертов, положительный эффект наиболее заметен в текстовой части академической работы. В будущем большие языковые модели повысят эффективность исследований за счет автоматизации различных задач, связанных с написанием и публикацией статей. Точно так же они могут избавить ученых от растущей административной отчетности.

В результате такой помощи освобождается время для дальнейших инноваций, так как исследователи смогут уделить основное внимание на содержание своих исследований и при этом эффективно донести его до более широкой аудитории.

Результаты исследования указывают на огромный потенциал больших языковых моделей. Хотя их преимущества перевешивают риски, мнения экспертов в области ИИ и цифровизации показывают, что важно решать проблемы, связанные с дезинформацией и потерей доверия к науке. Если мы будем относиться к LLM ответственно и придерживаться этических принципов, то мы сможем использовать их для максимизации положительного воздействия и минимизации потенциального вреда

— Доктор Бенедикт Фехер, автор исследования «Друг или враг? Изучение влияния больших языковых моделей на науку».

- Алексей Павлов

- Institut für Internet und Gesellschaft

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Главная тайна Черного моря разгадана: Ученые рассказали, почему там на дне очень прозрачная пресная вода

Чтобы найти ответ, исследователям пришлось заглянуть на 8 тысяч лет назад...

Марс отменяется: три причины, почему российские эксперты ставят крест на Красной планете

Почему пробирка с Марса опаснее любого астероида, как галактические лучи «взрывают» мозг и при чем тут Китай? Честный разбор рисков от Российской академии наук...

«Не повторяйте наших ошибок!» 100 лет борьбы с лесными пожарами обернулись катастрофой для США

Эксперты рассказали, почему, казалось бы, проверенная тактика только усугубила ситуацию с лесным огнем...

Секрет 14-го моря России: куда оно пропало и почему о нем снова заговорили?

Эксперты напоминают: Кроме Печорского, у России есть и 15-е «забытое» море, и оно тоже возвращается на карты...

Мегамонстры с 7-го этажа: в древних океанах шла такая война хищников, где у современных косаток не было бы ни единого шанса

Ученые рассказали, куда исчезли «боги» мезозойских морей и почему сейчас их существование было бы невозможно...

Мощнее леса в десятки раз: в ЮАР нашли «живые камни», которые выкачивают CO₂ с бешеной скоростью

Микробиалиты могли бы спасти Землю от потепления, но у этих «каменных насосов» есть один нюанс...

ДНК 4000-летней овцы оказалось ключом к древней тайне, стоившей жизни миллионам

Поразительно, но археологи нашли штамм древней чумы, кошмаривший всю Евразию, в самом таинственном российском городе — Аркаиме. Почему же так получилось?...

Супертелескоп James Webb только запутал ученых, а планета-«близнец» Земли стала еще загадочнее

Эксперты рассказали, почему самый мощный телескоп в истории не смог разобраться с атмосферой TRAPPIST-1e. Аппарат не виноват. Но тогда кто?...

Грядет научный прорыв: Зачем в последние годы ученые по всему миру создают очень странные компьютеры?

Новые аппараты… не просто живые: они стирают различия между ЭВМ и человеческим мозгом...

Новое исследование показало: если бы не этот «российский ген», древние люди вряд ли бы заселили Америку

Ученые рассказали, почему Алтай в ДНК — это главный секрет феноменального здоровья индейцев...

20-летнее наблюдение со спутников «сломало климат»: Теперь ученым придется полностью менять все теории

Зато теперь понятно, почему в двух близких городах могут быть... разные времена года...

Она нам больше не праматерь! Почему легендарную Люси могут «изгнать» из числа наших предков?

Ведущие антропологи мира схлестнулись в настоящей войне. Кто же окажется победителем?...

Еще один страх для авиапассажиров: космические лучи могут вызвать внезапное падение самолета

Эксперты подтверждают: предсказать такие катастрофы практически невозможно. Что же теперь делать?...