Как ChatGPT и другие большие языковые модели помогают бороться с дезинформацией

Большие языковые модели (LLM) способны быстро генерировать тексты, которые бывает трудно отличить от написанных людьми. Эти модели стали все более популярными после публичного релиза ChatGPT — высокоэффективной LLM, разработанной OpenAI.

Последние исследования, оценивающие LLM, в основном тестировали их способность создавать хорошо написанные тексты: эссе, документы или, к примеру, эффективный компьютерный код. Но помимо этого языковые модели потенциально могут помочь людям с решением проблемы дезинформации в СМИ.

Кевин Матте Карамансьон, исследователь из Университета Висконсин в Стаут, провел исследование, оценивающее способность самых известных больших языковых моделей определять, является ли новость правдивой или фальшивой. Результаты его работы могут способствовать будущему использованию LLM для борьбы с дезинформацией в интернете.

— Кевин Матте Карамансьон

Исследователи оценили производительность больших языковых моделей, используя тестовый набор из 100 проверенных фактов новостных материалов от независимых факт-чекеров. Затем они представили каждый из этих новостных материалов моделям в контролируемых условиях, а после классифицировали их ответы на одну из трех категорий: «Правда», «Ложь» и «Частично Правда/Ложь». Эффективность моделей измерялась на основе того, насколько точно они классифицировали материалы по сравнению с независимыми агентствами.

В исследовании были использованы четыре LLM: Chat GPT-3.0 и Chat GPT-4.0 от Open AI, Bard/LaMDA от Google и Bing AI от Microsoft. Ученый дал этим моделям одни и те же новостные материалы, которые были предварительно проверены, и затем сравнил способность определять достоверность информации.

— Кевин Матте Карамансьон.

Исследователь подчеркнул, что планирует продолжать тестирования, изучать новые LLM и взаимодействие между когнитивными способностями человека и технологией ИИ в области проверки фактов из СМИ.

Последние исследования, оценивающие LLM, в основном тестировали их способность создавать хорошо написанные тексты: эссе, документы или, к примеру, эффективный компьютерный код. Но помимо этого языковые модели потенциально могут помочь людям с решением проблемы дезинформации в СМИ.

Кевин Матте Карамансьон, исследователь из Университета Висконсин в Стаут, провел исследование, оценивающее способность самых известных больших языковых моделей определять, является ли новость правдивой или фальшивой. Результаты его работы могут способствовать будущему использованию LLM для борьбы с дезинформацией в интернете.

Вдохновением для моей последней статьи послужила необходимость понять возможности и ограничения различных LLM в борьбе с дезинформацией. Цель работы — тщательно проверить умение этих моделей различать факты от вымысла, используя контролируемую симуляцию и проверенные факты в качестве примера.

— Кевин Матте Карамансьон

Исследователи оценили производительность больших языковых моделей, используя тестовый набор из 100 проверенных фактов новостных материалов от независимых факт-чекеров. Затем они представили каждый из этих новостных материалов моделям в контролируемых условиях, а после классифицировали их ответы на одну из трех категорий: «Правда», «Ложь» и «Частично Правда/Ложь». Эффективность моделей измерялась на основе того, насколько точно они классифицировали материалы по сравнению с независимыми агентствами.

В исследовании были использованы четыре LLM: Chat GPT-3.0 и Chat GPT-4.0 от Open AI, Bard/LaMDA от Google и Bing AI от Microsoft. Ученый дал этим моделям одни и те же новостные материалы, которые были предварительно проверены, и затем сравнил способность определять достоверность информации.

Мы провели сравнительную оценку основных LLM на предмет способности различать правду от обмана. Было обнаружено, что Chat GPT-4.0 от OpenAI превосходит аналоги. Тем не менее, все языковые модели гораздо хуже людей в факт-чекинге, что подчеркивает незаменимость когнитивных способностей человека. Эти результаты могут привести к развитию возможностей ИИ в области проверки фактов при обеспечении сбалансированной, симбиотической интеграции с навыками человека.

— Кевин Матте Карамансьон.

Исследователь подчеркнул, что планирует продолжать тестирования, изучать новые LLM и взаимодействие между когнитивными способностями человека и технологией ИИ в области проверки фактов из СМИ.

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

Парадокс Великой Зеленой стены: Китай посадил 78 миллиардов новых деревьев, но климат стал только хуже. Как так вышло?

Ученые назвали причины, почему самый грандиозный экологический проект за всю историю в итоге обернулся головной болью для миллионов китайских граждан...

Людовик XIV умер совсем не от гангрены: ученые сумели раскрыть истину лишь 310 лет спустя

Эксперты говорят: французский король был обречен. Медикам того времени была совершенно неизвестна его болезнь...

Необъяснимые аномалии в тайге на Дальнем Востоке: читаем походные дневники военного разведчика и писателя Владимира Арсеньева

Часть первая: свет в ночном море, мираж «фата-моргана» и почти моментальное замерзание воды...

Меньше трех дней до конца света на орбите: почему программа CRASH Clock бьет тревогу?

Сотрудники Маска уверяют, что у них все под контролем. Но эксперты сравнивают орбиту с карточным домиком. Кто же прав?...

Что стоит за таинственными аномалиями в дальневосточной тайге? Продолжаем читать походные дневники военного разведчика и писателя Владимира Арсеньева

Часть вторая: снежная гроза, феномен моретрясения и встреча со «снежным человеком»...

Темная сторона Рима: выяснилось, что Империя веками «выкачивала» здоровье из покоренных народов

Новые находки заставили ученых признать: для простых людей римский «прогресс» был скорее приговором, чем спасением. Но почему же так вышло?...

Марс отменяется: три причины, почему российские эксперты ставят крест на Красной планете

Почему пробирка с Марса опаснее любого астероида, как галактические лучи «взрывают» мозг и при чем тут Китай? Честный разбор рисков от Российской академии наук...

Встречи с неведомым: завершаем чтение дневников разведчика и писателя Владимира Арсеньева

Часть третья: таинственный огонь в лесу, свет из облаков, призрак в тумане и странный дым на море...

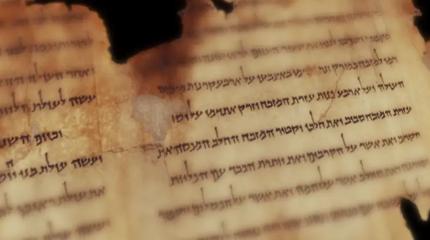

Загадочная письменность Б из пещер у Мертвого моря наконец-то расшифрована

Ученые «ломали» древний шифр эпохи Христа более 70 лет, но результат разочаровал многих. Почему?...

«Не повторяйте наших ошибок!» 100 лет борьбы с лесными пожарами обернулись катастрофой для США

Эксперты рассказали, почему, казалось бы, проверенная тактика только усугубила ситуацию с лесным огнем...

Первая «чернокожая британка» оказалась белой: новое исследование заставило историков полностью пересмотреть портрет женщины из Бичи-Хед

Почему ученые так сильно ошиблись с ее внешностью? И стоит ли после этого доверять реконструкциям по ДНК?...

ДНК 4000-летней овцы оказалось ключом к древней тайне, стоившей жизни миллионам

Поразительно, но археологи нашли штамм древней чумы, кошмаривший всю Евразию, в самом таинственном российском городе — Аркаиме. Почему же так получилось?...