NVIDIA сделала инструмент с открытым исходным кодом для создания более безопасных и защищенных моделей ИИ

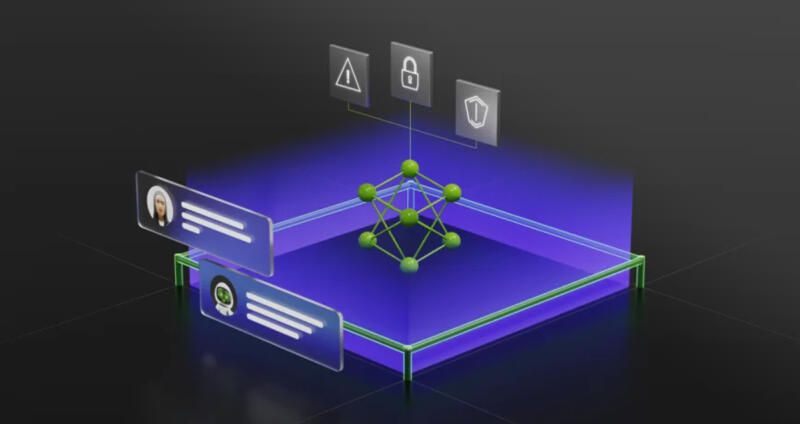

В марте NVIDIA продемонстрировала AI Foundations, службу, которая позволяет компаниям обучать большие языковые модели (LLM) на собственных данных. Сегодня компания представляет NeMo Guardrails — инструмент, призванный помочь разработчикам обеспечить точность, корректность и безопасность своих приложений для генеративного ИИ.

NeMo Guardrails позволяет разработчикам программного обеспечения применять три различных типа ограничений для своих собственных LLM. В частности, фирмы могут устанавливать «тематические барьеры». Это не позволят приложениям затрагивать темы, для обсуждения которых они не были обучены.

Например, NVIDIA предполагает, что благодаря такому обучению чат-бот службы поддержки клиентов будет отказываться отвечать на вопрос о погоде. Компании также могут устанавливать ограничения безопасности, которые гарантируют, что их LLM получают точную информацию и подключаются только к верифицированным приложениям.

Согласно NVIDIA, NeMo Guardrails работает со всеми LLM, включая ChatGPT. Более того, компания утверждает, что разработчики почти любого уровня смогут использовать новое программное обеспечение.

— Nvidia.

Поскольку NeMo Guardrails имеет открытый исходный код, NVIDIA отмечает, что он также будет работать со всеми инструментами, которые уже используют корпоративные разработчики.

NVIDIA внедряет NeMo Guardrails в свой фреймворк NeMo для создания генеративных моделей ИИ. Корпоративные клиенты могут получить доступ к NeMo через программную платформу AI Enterprise. NVIDIA также предоставляет платформу через AI Foundations.

— Nvidia.

NeMo Guardrails позволяет разработчикам программного обеспечения применять три различных типа ограничений для своих собственных LLM. В частности, фирмы могут устанавливать «тематические барьеры». Это не позволят приложениям затрагивать темы, для обсуждения которых они не были обучены.

Например, NVIDIA предполагает, что благодаря такому обучению чат-бот службы поддержки клиентов будет отказываться отвечать на вопрос о погоде. Компании также могут устанавливать ограничения безопасности, которые гарантируют, что их LLM получают точную информацию и подключаются только к верифицированным приложениям.

Согласно NVIDIA, NeMo Guardrails работает со всеми LLM, включая ChatGPT. Более того, компания утверждает, что разработчики почти любого уровня смогут использовать новое программное обеспечение.

Не нужно быть экспертом по машинному обучению или специалистом по данным, чтобы пользоваться NeMo Guardrails

— Nvidia.

Поскольку NeMo Guardrails имеет открытый исходный код, NVIDIA отмечает, что он также будет работать со всеми инструментами, которые уже используют корпоративные разработчики.

NVIDIA внедряет NeMo Guardrails в свой фреймворк NeMo для создания генеративных моделей ИИ. Корпоративные клиенты могут получить доступ к NeMo через программную платформу AI Enterprise. NVIDIA также предоставляет платформу через AI Foundations.

NVIDIA создала NeMo Guardrails — продукт нескольких лет исследований — и открыла его исходный код, чтобы внести вклад в развитие сообщества разработчиков и безопасности ИИ. Вместе наши усилия по созданию правил и ограничений для ИИ помогут компаниям привести свои интеллектуальные услуги в соответствие с требованиями безопасности, конфиденциальности и корректности

— Nvidia.

- Алексей Павлов

- Nvidia

Наши новостные каналы

Подписывайтесь и будьте в курсе свежих новостей и важнейших событиях дня.

Рекомендуем для вас

32 удивительных подарка за последние 20 лет: ученые пытаются понять, за что косатки «балуют» людей

Природная доброта? Любопытство? Желание выйти на контакт?...

Ученые и режиссеры все время обманывали нас насчет динозавров

Оказалось, древние ящеры бегали в четыре раза медленнее, чем считалось....

Уникальная находка в Нидерландах: археологи обнаружили римский лагерь далеко за пределами Империи

Как лидар и искусственный интеллект нашли объект-«невидимку» II века....

«Вертолетная» конструкция да Винчи может сделать беспилотники тише, быстрее и даже дешевле

Ученые поражены, насколько разработка Леонардо опередила время....

Историки задались вопросом, как же пах Древний Рим

Боимся, ответ вам может очень не понравиться....

Ученые хотят создать хранилище микробов, чтобы те… не вымерли

Звучит кошмарно, но на самом деле от этого зависит судьба всего человечества....

Череп ребенка-«пришельца» из Аргентины оказался вполне земным

Эксперты рассказали в подробностях, как могла появиться «инопланетная» форма головы....