В сегодняшнем материале мы поговорим о том, какие последствия это может иметь для будущего самой технологии, а также будущего всего человечества.

Что сделали японские ученые?

Ю Такаги, 34-летний нейробиолог и доцент университета Осака, обнаружил, что искусственный интеллект может декодировать мозговую активность в читаемый формат. Это вызвало волну беспокойства среди ведущих технологических лидеров, таких как Илон Маск и Стив Возняк, которые в последнее время публично призывают к приостановке развития ИИ из-за глобальных рисков для общества и человечества.

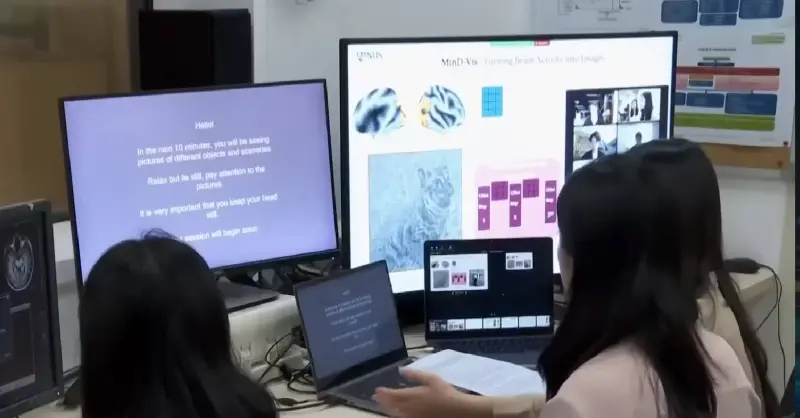

Такаги и его напарник по проекту Синдзи Нисимото использовали Stable Diffusion, модель глубокого обучения ИИ, разработанную в Германии в 2022 году. В результате проведенной работы она смогла проанализировать мозговые сканы испытуемых, которым показывали до 10 000 изображений внутри магнитно-резонансного томографа. После того, как Такаги и Нисимото построили простую модель для «перевода» мозговой активности в читаемый формат, Stable Diffusion сгенерировала высококачественные изображения, которые сильно походили на оригиналы, показанные испытуемым. ИИ мог сделать это, несмотря на то, что ему заранее не показывали картинки или не обучали его каким-либо способом воспроизводить результаты.

Мы действительно не ожидали такого результата. Я до сих пор помню, когда увидел первые (сгенерированные ИИ) изображения. Я пошел в ванную, посмотрел на себя в зеркало, увидел свое лицо и подумал: «Хорошо, это нормально. Может быть, я схожу с ума»

— Ю Такаги.

Значит ли это, что ИИ может читать мысли?

Такаги подчеркнул, что разработанная им технология на данный момент не представляет собой буквальное чтение мыслей — ИИ может производить только изображения, которые человек видел.

Это не чтение мыслей. К сожалению, возникло множество недоразумений с нашим исследованием. К примеру, мы не можем декодировать воображение или сны; мы считаем, что надеяться на подобное в скором времени слишком оптимистично. Но, конечно, технология имеет потенциал в будущем

— Ю Такаги.

Однако этот факт не уменьшает обеспокоенности относительно, будущего использования подобной технологии в рамках более широкого дебата о рисках, связанных с ИИ в целом. В недавнем открытом письме технологические лидеры, включая основателя Tesla Илона Маска и сооснователя Apple Стива Возняка, уже призвали к приостановке развития ИИ, а общественное опасение относительно ИИ порой доходит до критического уровня.

Несмотря на свой энтузиазм, Такаги признает, что опасения вокруг технологии чтения мыслей не лишены оснований, учитывая возможность злоупотребления со стороны тех, кто имеет злонамеренные мотивы или может применить технологию без согласия со стороны испытуемых.

Для нас действительно важны проблемы конфиденциальности. Если правительство или другие институты власти смогут читать мысли людей, это может стать очень серьезной проблемой. Необходимо обсуждение подобных вопросов на высшем уровне, чтобы гарантировать, что такой сценарий не может быть реализован

— Ю Такаги.

Существуют ли принципы этичного чтения мыслей?

В одной из последних работ по схожей теме, написанной для Женевского университета специалисты по этике и фундаментальным нейронаукам из Швейцарии постарались ответить на эти и другие этические и правовые вопросы, а также предложили ряд решений для развития и применения технологии.

В своей работе авторы анализируют этические проблемы связанные с реально применяемыми устройствами для декодирования речи на основе активности мозга. Такая технология, как правило, применяется для помощи людям с ограниченными речевыми и двигательными функциями. В последнее время возникло все больше предположений о возможности применения технологии для анализа поведения людей с точки зрения правового контроля, что ставит ряд важных этических проблем. В ходе исследования ученые выделили четыре базовых правила, придерживаясь которых технологию можно считать этичной в привычном социальном понимании:

- Принцип информированного согласия: пользователи должны быть полностью осведомлены о целях, рисках и выгодах участия в проектах, связанных с записью мозга, и иметь возможность отказаться от них в любой момент.

- Принцип приватности: данные о мозговой активности пользователей должны быть защищены от несанкционированного доступа, использования или раскрытия, а также уважать их личную сферу и достоинство.

- Принцип контроля: пользователи должны иметь контроль над тем, как и когда их мозговая активность записывается, обрабатывается или декодируется, а также над тем, как они хотят выражать свои мысли или чувства.

- Принцип личной идентичности: пользователи должны сохранять свое чувство самости и автономии при использовании технологий записи мозга, а также учитывать возможные психологические или социальные последствия.

Несмотря на то, что это уже не первая работа, которая стремится дать ответ на фундаментальные этические вопросы, связанные с технологией анализа мыслительной активности, дебаты по поводу правил и принципов ее применения возникают регулярно. Как в научной, так и в правовой среде все еще нет единого мнения по поводу того, что можно считать окончательным решением этого вопроса.

Исследование Такаги и Нисимото породило большое количество ажиотажа в технологическом сообществе, которое уже было достаточно электризовано стремительными достижениями в области ИИ, включая выпуск сверхэффективного ChatGPT, и последние заявления об опасности искусственного интеллекта. Хотя полученная командой технология не подразумевает чтение мыслей в прямом смысле этого слова, она показывает потенциал ИИ для анализа и визуализации мозговой активности.

Понятно, что технология может иметь как положительные, так и отрицательные последствия для будущего науки, медицины, права и этики. Также ясно, что обсуждение допустимости интеграции искусственного интеллекта с человеческим сознанием будет оставаться актуальным все время, пока в научной и технологической среде существуют амбиции по реализации такой технологии.